Hüter des Golden Records

![[shutterstock:83677336, Mny-Jhee]](https://e3mag.com/wp-content/uploads/2016/11/ShutterstockTitelbild.jpg)

Wenn es um Effizienzsteigerungen und Kosteneinsparungen geht, haben Unternehmen schnell offene Ohren.

„Und genau darum geht es beim Stammdatenmanagement“

definiert CEO Monika Pürsing und legt damit gleich zu Beginn des E-3 Gesprächs die Richtung fest.

Modernes Datenmanagement ist keine technische Disziplin, sondern eine unternehmerische Herausforderung für das ganze Unternehmen. Die SAP-Basis muss hier ebenso an Bord wie die Fachabteilungen.

Ursache und Wirkung

Laut allgemeinen Schätzungen liegt der negative Effekt schlechter Datenqualität bei acht bis zwölf Prozent des operativen Gewinns.

„Schlechte Datenqualität kostet also richtig Geld“,

weiß auch Monika Pürsing und sie nennt die Ursachen:

„Der Grund dafür ist in einem oftmals vollkommen ineffizienten ,Datenmanagement‘ zu suchen, wenn man davon überhaupt sprechen kann. Historisch wild gewachsene Daten, voneinander abgeschottete Datensilos, Kompetenzwirrwarr, aufwändige manuelle Datenpflege, komplexe, umständliche Prozesse, regelmäßiges ,Fire Fighting‘ bei Datenproblemen, keine unternehmensinternen Richtlinien für den Umgang mit Daten, kein ,Golden Record‘ – um mal einige der wesentlichen Aspekte zu nennen.“

Ein professionelles Stammdatenmanagement wird darüber hinaus durch Entwicklungen wie Big Data, Internet der Dinge und Industrie 4.0, Predictive Analytics etc. wichtiger.

„Das Internet der Dinge, Industrie 4.0, die Digitalisierung der Wertschöpfungsketten sind wichtige aktuelle Treiber für das Thema Datenqualität“

„Hinzu kommen Business Intelligence und Big Data Analytics. Für die wirksame Auswertung und Nutzung von Daten muss die Datenqualität stimmen. Der Einsatz von Verarbeitungs- und Analysemethoden kann nur dann einen monetären Wert aus Big Data generieren, wenn die Daten ,stimmen‘. Aus ,schlechten‘ Daten kann es keine ,guten‘ Informationen geben. Auswertungen oder Planungen sind fehleranfällig, wenn sie nicht auf vollständigen, eindeutigen und ,richtigen‘ Daten basieren.“

Die Wirkung: Die Annahme, dass Prognosen nur so gut sein können wie die Daten, auf denen sie basieren, klingt plausibel.

Im Rahmen einer Bachelorarbeit an der Hochschule der Medien (HdM) Stuttgart wurde dieser Zusammenhang nun erstmals empirisch untersucht und anhand einer konkreten Testreihe bestätigt.

Der Autor der Arbeit, Paul Titze, Student am Fachbereich Information und Kommunikation des Studiengangs Wirtschaftsinformatik und digitale Medien an der HdM, überprüfte mithilfe verschiedener Testszenarien, in denen Datenanalysen mithilfe von Stammdaten verschiedener Qualität durchgeführt wurden, den Zusammenhang zwischen qualitativ hochwertigen Stammdaten und den Ergebnissen der Analyse unter anderem mittels Machine Learning.

Ergebnis: Vor allem beim Machine Learning, bei dem die Stammdaten die Grundlage für das Lernen des Algorithmus bilden, konnten mit einer durch Stammdatenmanagement qualitativ hochwertig aufbereiteten Datengrundlage deutlich bessere Vorhersagen erzielt werden als beim Machine Learning mit einem unbehandelten Datenset.

„Über Datenqualität wird in der Tat schon lange geredet“ „Aber der Druck auf die Unternehmen wächst mehr und mehr, das Thema wirklich ernst zu nehmen und etwas zu tun.“

Die Datenmengen nehmen rasant zu. Nur viele Daten bringen den Unternehmen aber wenig. Ohne das Erkennen von Zusammenhängen, Bedeutungen und Mustern sind sie weitgehend wertlos.

Laut einer PwC-Studie aus dem Jahr 2014 sind für die Zukunft branchenübergreifend 90 Prozent aller Unternehmen davon überzeugt, dass die Fähigkeit, große Datenmengen effizient zu analysieren und effektiv zu nutzen, für den Erfolg ihres Geschäftsmodells von entscheidender Bedeutung sein wird.

„Um diese Fähigkeit zu entwickeln und im Unternehmen zu verankern, bedarf es einer wirkungsvollen Data Governance, also einheitlicher Prozesse und Verantwortlichkeiten für Dateneingabe, -freigabe und -pflege“

Algorithmen und Datenstrukturen

„Ohne Data Governance, also kontrollierte Prozesse und klare Verantwortlichkeiten, geht es nicht. Sie bilden die Grundlage, auf der wir mit unserer Stammdatenlösung ZetVisions SPoT aufsetzen“ „Das ist kein Datenqualitäts-Tool für die kurzfristige Datenbereinigung, sondern eine nachhaltig wirksame Multi-Domain-MDM-Lösung, mit der Unternehmen einen ,Golden Record‘ für beispielsweise Kunden, Produkte und Lieferanten schaffen und Wechselwirkungen zwischen diesen Domänen erkennen können. Sie erhalten einen Rundumblick auf die Stammdaten über alle Domänen hinweg.“

Momentan ist ein spannendes Wechselspiel zwischen Big Data und Algorithmic Business zu beobachten. Das eine kann ohne das andere wohl nicht existieren – in beiden Fällen kommt es immer auf die Qualität an.

Bereits Ex-SAP-Technikvorstand Vishal Sikka erkannte, dass nur eine schnelle Datenbank für Big Data zu wenig ist, es braucht auch Mathematik und Algorithmen. SAP meint, dass Master Data die „DNA“ eines Unternehmens ist. Stimmt das?

„Das sehe ich auch so: Stammdaten bilden das Rückenmark der Geschäftsprozesse“ „Auf ihrer Grundlage fallen Entscheidungen, sie regeln den Geschäftsprozess. Stammdaten sind eine wichtige übergreifende Komponente, die in operativen Prozessen und Unternehmensentscheidungen ebenso beteiligt ist wie bei Datenauswertungen und -analysen oder Produkten und Dienstleistungen.“

Disruptive digitale Technologien wie Algorithmen, künstliche Intelligenz, Bots sowie Chatbots verändern bereits die gesamte Geschäftswelt.

Das IT-Research- und Beratungsunternehmen Gartner geht davon aus, dass das sogenannte Algorithmic Business eine noch größere Anzahl disruptiver Entwicklungen hervorbringen und so neue Industrien schaffen wird.

Um die neuen digitalen und auf Algorithmen basierenden Funktionalitäten und Geschäftsmodelle zu unterstützen, müssen CIOs eine Technologieplattform für das digitale Business entwickeln und einsetzen.

„Daten, Analytics und künstliche Intelligenz treiben das Algorithmic Business voran, sodass es weiter wachsen und Unternehmen verändern wird“„Dieses Wachstum hält unvermindert an, da sich Algorithmen an der unaufhaltsam steigenden Datenmenge bereichern.“

Mehr als 500.000 neue Geräte verbinden sich pro Stunde mit dem Internet und jedes davon trägt zum unvermeidlichen Datenwachstum bei.

„Kerngeschäftsprozesse und Stammdaten sind eng miteinander verzahnt“„Nur optimal aufeinander abgestimmt, verursachen sie keine zusätzlichen Kosten im gesamten Unternehmen. Als Herzstück eines jeden Unternehmens und als Grundlage von Unternehmensentscheidungen wirken sich verlässliche Stammdaten positiv auf die Prozesseffizienz aus und sorgen für Kosteneinsparungen.“

Marktforscher Lünendonk befragte 103 Managementberater, knapp drei Viertel davon gaben an, analytische Software zu nutzen. Häufig handelt es sich dabei noch um klassische Tools wie Excel oder Standardwerkzeuge von Microsoft oder SAP sowie Eigenentwicklungen.

Agile und interaktive Software-Tools, die in der Regel eine tiefere Analyse zulassen, kommen bei noch nicht einmal der Hälfte der befragten Berater zum Einsatz.

Hier besteht noch ein großer Nachholbedarf, denn 77 Prozent der Consultants sind voll oder zu einem hohen Teil der Ansicht, mit Hilfe von analytischer Software und Algorithmen Zusammenhänge besser zu erkennen und dadurch Beratungsprojekte besser umzusetzen.

Predictive Analytics

„Wenn Predictive Analytics valide Ergebnisse liefern soll, ist eine hohe Datenqualität zwingende Voraussetzung“

Dazu ein Beispiel von GE, das Sokwoo Rhee, Leiter des Cyber-Physical Systems Program am National Institute of Standards and Technology in den USA, geschildert hat.

GE hat früher Flugzeugmotoren zu einem einheitlichen Preis verkauft. Heute geben sie die Motoren im Rahmen eines Subskriptionsmodells gratis ab und berechnen eine monatliche oder jährliche Nutzungsgebühr, die mit einer Garantie verbunden ist.

Kunden müssen sich über Reparaturen oder Ähnliches keine Gedanken machen. Sie können darauf vertrauen, dass die Motoren anspringen und laufen, wenn sie den Schalter betätigen.

Damit dieses Modell funktioniert, muss GE genau wissen, wann die Motoren auszufallen drohen. Werden sie zu früh ersetzt, verliert das Unternehmen Geld, denn die Motoren hätten noch weitere Erträge generieren können.

Warten sie dagegen zu lange, kann das verhängnisvolle Folgen haben.

Um herauszufinden, wann genau die Motoren auszufallen drohen, sammelt GE die Daten von vielen Hundert Sensoren und wertet sie mithilfe von Big Data Analytics aus.

„Stammdaten sind ein kritischer Erfolgsfaktor, um diese analytischen und vorausschauenden Erkenntnisse gewinnen zu können“ „Natürlich sollte das Thema Datenqualität alle im Unternehmen vorhandenen Daten umfassen“

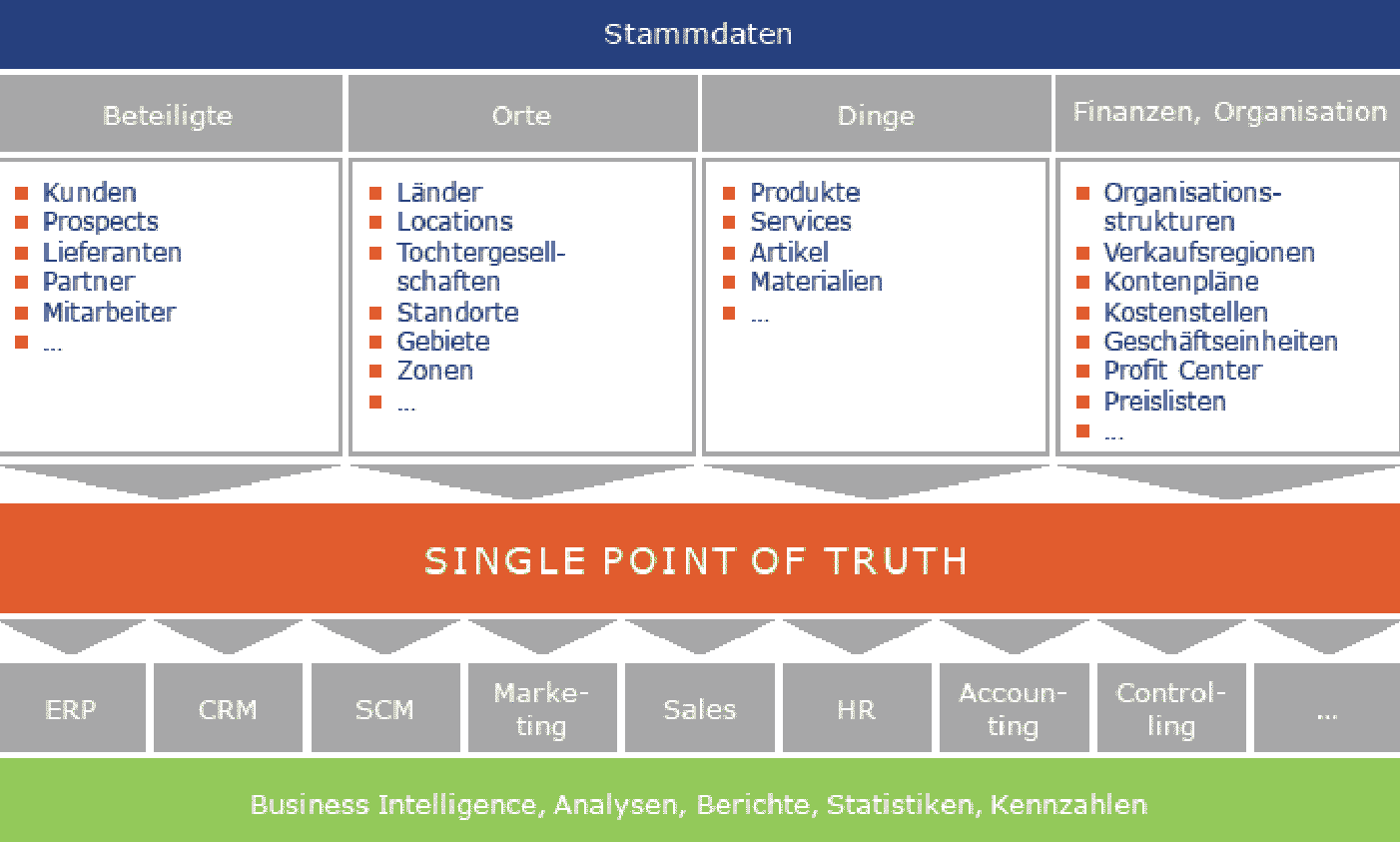

Außerdem benötigt nicht nur das ERP Stammdaten, sondern beispielsweise auch das Supply Chain Management, das Customer Relationship Management, Marketing, Sales, HR, Accounting, Controlling. Insoweit ist das Thema Stammdaten dem ERP-Thema übergeordnet und Predictive Analytics ist auch nur ein Teil davon, wenn auch ein immer wichtigerer.

„Einzellösungen für die verschiedenen Stammdatendomänen sind nicht sinnvoll, da es am Ende wieder diverse Datensilos gibt“ „Bei einem Stammdatenprojekt ist es durchaus sinnvoll, zunächst mit nur einer Domäne – beispielsweise Kundenstammdaten – zu starten.“

Unternehmen sollten aber darauf achten, von vornherein eine Multi-Domain-Lösung zu implementieren, mit der alle relevanten Stammdatendomänen abgedeckt werden können. Eine solche Lösung bietet die Möglichkeit, sukzessive das gesamte Master Data Management an einem Ort zu zentralisieren.

Und Monika Pürsing erklärt, dass man ZetVisions SPoT mit Content für Kunden– und Lieferantenstammdaten, Produktstammdaten und Finanzstammdaten ausliefert. Darüber hinaus können Unternehmen Stammdaten definieren, die nicht einer anderen Stammdatendomäne zugeordnet werden können.

Dabei kann es sich zum Beispiel um Organisationsstrukturen oder Referenzdaten wie Regionen- oder Länderhierarchien handeln.

Bei ZetVisions SPoT handelt es sich um nur ein Produkt, das dieselben Funktionalitäten wie Validierungsframework, Requests, Data Quality Dashboard, Datentransfer, Ad-hoc-Reporting, Hierarchien für alle Domänen bereitstellt.

Es gibt keine unterschiedlichen Roadmaps; Funktionsverbesserungen stehen allen Domänen zur Verfügung, beispielsweise die Massendatenpflege oder das Erstellen aus Vorlagen.

Datenqualität oder MDM

„Datenqualität und MDM sind nicht dasselbe“

Stammdatenmanagement ist das Zusammenfügen aller im Unternehmen befindlichen Informationen und Daten zu einem schlüssigen Ganzen, dem „Golden Record“, für beispielsweise Kunden, Produkte, Lieferanten.

Erst so lassen sich Wechselwirkungen zwischen diesen Domänen erkennen, und man erhält einen Rundumblick auf die Stammdaten über alle Domänen hinweg. Ein Master Data Management schafft somit die „eine Wahrheit“ für unterschiedliche Stammdatendomänen über den gesamten Geschäftsprozess.

Ein Nebeneffekt davon ist eine verbesserte und nachhaltige Datenkonsistenz und Datenqualität über den gesamten Geschäftsprozess hinweg. Vor allen aber wird die Prozesseffizienz und Performance durch die bereichsübergreifende Zusammenarbeit verbessert.

Datenqualität sagt dagegen etwas aus über die Korrektheit, Konsistenz, Zuverlässigkeit, Vollständigkeit, Genauigkeit und Aktualität von Daten – nicht nur von Stammdaten. Datenqualität ist also ein Teilaspekt des Stammdatenmanagements.

„MDM ist kein Thema allein für die IT. Es kann von der IT getrieben, muss aber von den betroffenen Fachbereichen getragen werden. Auch die Datenverantwortung sollte in den Fachbereichen liegen.“

Es ist nie zu spät, sich mit Datenqualität zu beschäftigen, ist die feste Meinung von Monika Pürsing:

„Wenn schlechte Datenqualität dazu führt, dass ein Unternehmen Geschäft oder Geld verliert, wird es allerdings höchste Zeit, sich mit dem Thema zu befassen. Nicht in ferner Zukunft, sondern gleich.“

Das ist dann der sogenannte Compelling Event, der auf die Frage „Warum jetzt“ eine klare Antwort gibt. Entwicklungen wie das Internet der Dinge, Industrie 4.0 etc. treiben das Thema Datenqualität weiter.

Für Vertagen und Vertrösten ist da kein Platz. Und noch etwas ist CEO Pürsing wichtig:

„Ob Daten das neue Öl sind, darüber wird seit rund zehn Jahren, seit dieses Diktum erstmals auftauchte, gerne philosophiert. Am Ende ist es dabei nicht entscheidend, ob Öl und Daten mehr unterscheidet, als sie gemeinsam haben. Entscheidend ist, sich immer wieder vor Augen zu führen, dass Daten in der digitalen Ökonomie werthaltiger Schmierstoff für Unternehmen und Wirtschaft sind. Daten sind zentraler Rohstoff des digitalen Wandels. Diese Erkenntnis allein sollte reichen, um die Beschäftigung mit Datenqualität nicht auf die lange Bank zu schieben.“

Des Weiteren müssen Verantwortlichkeiten definiert werden, Rollen wie Master Data Expert und Data Steward – Stammdatenmanagement geht über die reine Datenverwaltung und -verteilung hinaus.

„Aus unserer Sicht gehen MDM und MDG Hand in Hand. Data Governance ist essenziell für ein wirkungsvolles Stammdatenmanagement“

erklärt Pürsing.

Eine professionelle Softwarelösung liefert sodann die technische Unterstützung. MDM allein – ohne Data Governance – könnte auch nur ein HUB oder die Konsolidierung von Stammdaten sein – ohne die Definition von Regeln für den Umgang mit Daten und die Anpassung von Organisation, Strukturen und Prozessen.

„Stammdaten-Governance ist vorrangig ein organisatorisches Thema, Technologie ist nur unterstützend“,

weiß CEO Pürsing.

Und betriebswirtschaftlich ist das Thema insofern relevant, als Unternehmen ohne interne Richtlinien für den Umgang mit Daten, ohne einheitliche Prozesse und Verantwortlichkeiten für Dateneingabe, -freigabe und -pflege auf Dauer ein Problem mit ihrer Datenqualität haben.

„Und schlechte Datenqualität kostet Geld“

weiß die ZetVisions CEO.

Data Governance schafft den erforderlichen Ordnungs- und Steuerungsrahmen als organisatorische Grundlage, um ein Stammdatenmanagement im Unternehmen einführen zu können.

Hierbei sind die relevanten Rollen, Verantwortlichkeiten und Prozesse zu definieren. Beispielsweise sollte in den entsprechenden Policies festgelegt werden, wer für bestimmte Daten und die Einhaltung von Qualitätsstandards verantwortlich ist; welche Rollen die Mitarbeiter haben, die mit Daten hantieren, und wie diese mit Daten umzugehen haben; nach welchen Standards Daten erfasst werden (hier sollte definiert werden, welche Mindestanforderungen an Daten einzuhalten sind); und schließlich, welche Sicherheitsregeln zu beachten sind.

Um Data Governance wirkungsvoll in die Tat umzusetzen, kann ein Data Governance Office als institutionalisierte Daten-Autorität installiert werden, die die Nutzung von Daten innerhalb des Unternehmens festlegt.

Das Office besteht aus Vertretern der relevanten Geschäftsbereiche; dabei kann nach fachlichem Fokus (zentrale/dezentrale Vertriebsfunktionen, Finance, HR, IT) oder geografischem Fokus (alle Funktionen einer Landesvertretung) unterschieden werden.

Und abschließend: Was sind aus Sicht von ZetVisions die größten Herausforderungen beim Streben nach einer hohen Datenqualität?

„Es muss der Wille zur Veränderung gegeben sein, die Bereitschaft, Überkommenes infrage zu stellen. Wer das Management von Stammdaten professionell angehen möchte, wird nicht umhin kommen, alte Prozesse aufzubrechen und in bisherige ,Hoheitsgebiete‘ einzugreifen. Da gibt es manche ,Befindlichkeiten‘, die zu adressieren sind. Es müssen neue, einheitliche Prozesse definiert und Datenverantwortliche benannt werden.“