Ein gutes Werkzeug ist zu wenig

![[shutterstock:568907860, Saint A]](https://e3mag.com/wp-content/uploads/2017/02/shutterstock_568907860.jpg)

Getrieben durch die digitale Transformation erhalten Daten in Unternehmen eine bisher nicht gekannte Bedeutung. Der Anspruch an Qualität und Verfügbarkeit der Daten – im Sinne der Integration – steigt stark an.

Dem steht entgegen, dass die dafür notwendigen Prozesse und Werkzeuge des Informationsmanagements oft noch gar nicht eingeführt sind oder den Anforderungen nicht genügen.

Neben der Unsicherheit der korrekten Einschätzung der Kritikalität der Daten fehlen oft Kenntnisse, wie man aus Daten effektiv Informationen für die Steigerung der Wettbewerbsfähigkeit ableiten kann. Effiziente Geschäftsprozesse erfordern hochwertige Daten.

Führungskräfte sollten daher einen angemessenen Umgang mit den Unternehmensdaten etablieren.

Die Praxis zeigt, dass viele Fragestellungen heute nur unvollständig beantwortet werden können, z. B.:

- Welche Daten sind im Unternehmen grundsätzlich vorhanden?

- Wo befinden sich diese Daten, welche Qualität haben diese?

- Von wem und welchen Systemen werden diese Daten genutzt?

- Wer ist für die Daten verantwortlich?

- Welche Daten stellen einen Mehrwert für das Unternehmen dar?

- Welche Daten verursachen unnötige Kosten?

Unternehmen agieren in einem komplexen technisierten Umfeld, in dem Informationen zunehmend wertvoller und geschäftskritischer werden; die Daten müssen jedoch professionell gemanagt werden.

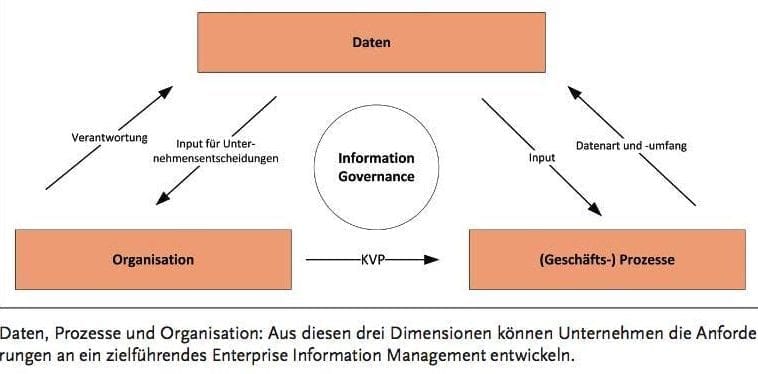

Ein valider Ansatz dafür betrachtet immer die Dimensionen “Daten”, “Prozesse” und “Organisation”. Aus diesen drei Dimensionen entwickeln sich die Anforderungen an das Enterprise Information Management. Sie müssen gemäß den Vorgaben der Information Governance ausgerichtet werden.

Diese ist mehr denn je eine strategische Aufgabe. Bezüglich Daten stellen sich Fragen nach der Qualität (Vorgaben und Prozesse), der Dateneffizienz/-integration (Datenarchitektur und eindeutige Verantwortung) und dem Management des Informationslebenszyklus (Vorgaben und Prozesse).

In vielen Unternehmen wurde erkannt, dass Datenmanagement ein „Fulltime Job“ ist und nicht nebenher erledigt werden kann. Wie jede neue Disziplin muss es zunächst aufgebaut werden.

In der Automobilindustrie wird gerade die Erfahrung gemacht, dass Elektrofahrzeuge nicht so einfach auf dem Markt zu etablieren sind. Deshalb ist man trotz langjähriger Erfahrung im Automobilbau dazu übergegangen, ganz neue Abteilungen für Elektrofahrzeuge zu gründen, um Fahrzeuge zur Serienreife zu bringen, die vom Kunden akzeptiert werden.

Ähnlich wird es Unternehmen im Informationsmanagement gehen, auch hier wird eine gewisse Lernkurve nicht vermeidbar sein. Es empfiehlt sich daher, für die ersten Schritte professionelle Unterstützung einzukaufen, da man sich so die ein oder andere schmerzliche Erfahrung sparen kann.

Zu Beginn ist die Verantwortlichkeit für das Informationsmanagement zu etablieren; dies ist Aufgabe der Unternehmensleitung. In vielen Organisationen wurde dazu die Rolle des Chief Data Officer (CDO) geschaffen.

Der CDO ist ein neuer Vertreter im C-Level: Er treibt die digitale Transformation im Unternehmen voran, übernimmt Verantwortung im Aufbau von Prozessen und Rollen für das Informationsmanagement und sorgt für ein klares Verständnis über die Datenarchitektur im Unternehmen.

Er wirkt für die unternehmensweite Durchsetzung der von seinem Bereich festgelegten und abgestimmten Information Governance.

SAP-Strategie

Der Stellenwert des Enterprise Information Management bei SAP steigt stark.

Die „neue“ Technologie Hana macht nur wirklich Sinn, wenn hochwertige Daten zur Verfügung stehen.

Was hilft eine Auswertung in Sekunden, wenn die darunterliegenden Daten minderwertig sind? Echtzeit ist nur sinnvoll, wenn die Datenbasis definiert und sauber ist.

S/4 Hana bietet heute schon umfangreiche Möglichkeiten, operative Daten der Business Suite direkt selbst zu verarbeiten. So entfallen der Datentransfer und die Datenverarbeitung in einem separaten Data Warehouse – ein signifikanter Zeitgewinn.

Fachbereiche sind imstande, umfangreiche Daten ohne die Nutzung eines BW-Systems sofort und in Echtzeit auszuwerten. Auch bei allen Szenarien des Internet of Things (IoT) sind Datenintegration und Datenqualität ein wesentlicher Erfolgsfaktor.

Und für die Erstellung von Vorhersagen (Predictive Analytics) in Echtzeit liegt es auf der Hand, dass nur eine gute Datenbasis gute Ergebnisse liefern kann.

SAP hat daher eine Offensive für eine bessere Integration und Datenqualität gestartet mit einer zunehmenden Zentralisierung und Konsolidierung, wie an der Werkzeug-Landschaft für Hana 2.0 ersichtlich ist.

Unter den Begriffen Hana Smart Data Access, Hana Smart Data Integration und Smart Data Quality werden Lösungen gesammelt und bereitgestellt.

Mit Hana Smart Data Integration, SAP Smart Data Quality und Hana Cloud Integration (HCI) wird ein klares Signal gesendet, wo SAP künftig die Hausaufgaben des Kunden sieht. Aber auch etablierte Werkzeuge wie z. B. SAP Master Data Governance (MDG) befinden sich in der Überarbeitung, um den Kunden besser bei seinen Aufgaben zu unterstützen.

Mit MDG können SAP-Business-Workflows genutzt werden, die z. B. den Datenverantwortlichen informieren, wenn Stammdaten geändert oder Duplikate erstellt werden.

Außerdem lassen sich Anforderungen an Compliance und Auditierung mit der Nachverfolgung aller Änderungen und Genehmigungsprozesse erfüllen.

Empfehlungen

Trotz der zahlreichen Werkzeuge im Umfeld von Enterprise Information Management kommt kein Unternehmen allein durch die Einführung von Werkzeugen ans Ziel.

Als Berater beginnen wir daher mit unseren Klienten beim Aufbau der notwendigen Organisation und unterstützen dies mit einer aussagekräftigen Analyse des Datenbestandes.

In diesem Kontext ist weniger wichtig zu wissen, wie viele Gigabyte an Daten wo liegen, als vielmehr, welche Daten im Unternehmen wo erzeugt werden, wem diese „gehören“, welche Wertigkeit diese für das Unternehmen haben und welchen gesetzlichen Anforderungen sie unterliegen.

Um diesen Aufgaben gerecht zu werden, sind wie erwähnt Rollen und Verantwortlichkeiten im Informationsmanagement anzupassen.

Neben dem CDO ist dies der Dateneigner (Data Owner), der für eine Daten-Domäne im Unternehmen verantwortlich ist – oft aus dem Bereich, der die größte Kenntnis über die entsprechenden Daten hat (z. B. Kundendaten im Vertrieb).

Ein Datenarchitekt (Data Architect) ist für eine ganzheitliche Datenarchitektur verantwortlich; er integriert Daten und setzt diese zueinander in Beziehung.

Ein Datensteward (Data Steward) unterstützt den Dateneigner bei der Qualitätssicherung von Daten und stellt im operativen Betrieb sicher, dass die Daten den Anforderungen an Korrektheit, Konsistenz, Relevanz und Vollständigkeit entsprechen.

Bestehende Rollen wie Business-Prozessmanager (Business Process Manager) müssen im Enterprise Information Management eingebunden werden.

Das Vorgehen ist immer ganzheitlich zu sehen, es erfordert ein Umdenken in der Wahrnehmung und im Umgang mit Daten beim oberen und mittleren Management.

Erst nachgelagert wird dann durch den Einsatz von Werkzeugen die qualitätsgesicherte Erzeugung und Bereitstellung der Daten in den Geschäftsprozessen unternehmensweit sichergestellt.

Das Alegri-White-Paper „SAP-Datenmanagement. Neue Herausforderungen mit Hana“ beleuchtet weitere Aspekte und kann kostenfrei angefordert werden.

Eckpunkte für die strategische Ausrichtung für Hana Data Integration

Adaptive Tooling:

Bereitstellung eines Werkzeugkastens, der durch ein flexibles Lizenzierungsmodell für unterschiedliche Technologien genutzt werden kann, ohne jedes Mal konkrete Komponenten lizenzieren zu müssen.

Hana-Centric:

Administration und Monitoring sowie Security werden komplett über Hana-Werkzeuge abgebildet.

Support Disparate Data for Digital Business:

Unterschiedlichste Datentöpfe können „out of the box“ zugänglich gemacht und im zentralen Hana-System verarbeitet werden.

Automated Data Provisioning:

Ein selbstlernendes System, das Daten aufspürt und bearbeitet, um diese dann performanceoptimiert bereitzustellen.

Data and Application Integration:

Unterstützung von Messaging und anderen Schnittstellen zur Nutzung von Daten- und App-Paradigmen.

Hybrid Deployment Model:

Die zur Verfügung stehenden Werkzeuge sind immer gleich, ob als Cloud Service oder als On-premise-Installation.