Virtualisation SAP - Un coup d'œil sous le capot

![[shutterstock.com : 725365669, Gorodenkoff]](https://e3mag.com/wp-content/uploads/2020/07/shutterstock_725365669.jpg)

Les avantages de la virtualisation dans l'environnement SAP sont bien connus. La réduction des coûts, les cycles de mise à jour plus courts, une plus grande flexibilité et le clonage de systèmes SAP, même de grande taille, en quelques minutes pour préparer et mettre en œuvre des mises à niveau, etc. sont en fait des arguments imparables.

Et pourtant, de nombreux propriétaires d'applications doutent de leur poids, car ils ont surtout en tête les données de performance en cours d'utilisation et la protection contre les pertes de données.

Et ils n'ont pas tort, car après tout, il est essentiel que les utilisateurs puissent travailler de manière productive avec les différentes applications SAP et accomplir les tâches professionnelles.

Un environnement SAP virtualisé doit donc prouver que les inquiétudes des responsables d'applications sont infondées. Cela vaut également pour les systèmes SAP, y compris les environnements Hana, S/4 et NetWeaver, qui reposent sur le logiciel HCI de Nutanix.

Il vaut donc la peine de jeter un coup d'œil "sous le capot", pour ainsi dire, afin de mieux comprendre que les avantages des paysages SAP virtualisés esquissés ci-dessus ne se font pas au détriment de la performance en cours d'exploitation.

Dans le logiciel Nutanix, il est possible d'exploiter n'importe quelle combinaison d'applications dans son propre centre de données et celles-ci peuvent en outre évoluer dans des ordres de grandeur qui ne sont autrement possibles que lors de l'exploitation dans un cloud public.

La plateforme fournit des valeurs très élevées en ce qui concerne le débit d'entrée/sortie (mesuré en IOPS, c'est-à-dire en opérations d'entrée/sortie par seconde) et, en même temps, des retards très faibles dans les temps de réponse.

Les mesures effectuées par Nutanix ont démontré qu'il est préférable d'augmenter le nombre de machines virtuelles (VM) contenant des bases de données afin de tirer pleinement parti des performances de la plateforme, plutôt que de déployer un grand nombre d'instances de bases de données dans une seule VM.

En ce qui concerne le débit d'entrée/sortie, Nutanix fournit, via sa "Distributed Storage Fabric" (DSF), les valeurs de débit et les exigences transactionnelles nécessaires, même pour des bases de données transactionnelles et analytiques très complexes, y compris Hana.

Mise à l'échelle et localisation des données

L'architecture complète de l'infrastructure logicielle hyperconvergée de Nutanix suit une approche "web-scale" (voir figure 1, page 47) : Des nœuds avec une très grande puissance de calcul, c'est-à-dire des serveurs, sont utilisés. Des hyperviseurs standard fonctionnent sur ces nœuds.

Il s'agit notamment de vSphere/ESXi de VMware, d'Hyper-V de Microsoft ou de l'hyperviseur Nutanix AHV certifié pour NetWeaver, Hana et S/4. Le matériel d'un tel nœud se compose de processeurs, de mémoire de travail et de composants de stockage locaux - il peut s'agir de SSD à base de flash et/ou de disques durs SATA ainsi que de stockage NVMe avec des capacités de stockage élevées.

Sur chacun de ces nœuds fonctionnent des machines virtuelles, comme sur un système hôte habituel pour les VM. En outre, une VM de contrôle est utilisée pour chaque nœud et fournit toutes les fonctions pertinentes de Nutanix.

Cette couche intermédiaire constitue le DSF et est ainsi responsable de la mise à disposition de tous les composants de stockage locaux à tous les nœuds, pour ainsi dire sous la forme d'un pool uniforme.

On peut également imaginer le DSF comme une sorte de périphérique de stockage virtuel qui offre les SSD et les disques durs locaux à tous les nœuds (via le protocole NFS ou SMB) pour le stockage des données des différentes VM. Les différentes VM d'un cluster écrivent les données dans le DSF, comme s'il s'agissait d'un stockage partagé normal.

Le DSF poursuit ici une tâche importante : il stocke toujours les données le plus "près" possible de la VM concernée. Cela se fait par un stockage le plus local possible : si une VM fonctionne sur le nœud A, les données correspondantes de cette VM sont généralement également stockées sur ce nœud.

Cela permet d'atteindre une vitesse d'accès aux données aussi élevée que possible, sans que cela n'entraîne de dépenses importantes au niveau des composants de stockage.

Ce principe de localité des données est complété par une gestion redondante des données lorsque celles-ci doivent être hautement disponibles et sont donc stockées sur plusieurs nœuds.

Grâce à ce concept, l'infrastructure basée sur le logiciel HCI de Nutanix évolue de manière linéaire d'une configuration à trois nœuds seulement à un nombre de nœuds illimité.

Cela présente de grands avantages pour les entreprises, car en ajoutant d'autres nœuds, il est possible de faire croître l'interconnexion à l'extrême en quelques clics, sans devoir réfléchir davantage à la connexion des nœuds entre eux.

En outre, le DSF offre une multitude de fonctionnalités importantes de gestion des données, comme le "data tiering" à l'échelle du cluster, qui permet de déplacer automatiquement les données vers des périphériques de stockage plus ou moins rapides en fonction de la fréquence d'accès - "hot data" versus "cold data".

Flux de données et fonctions de stockage

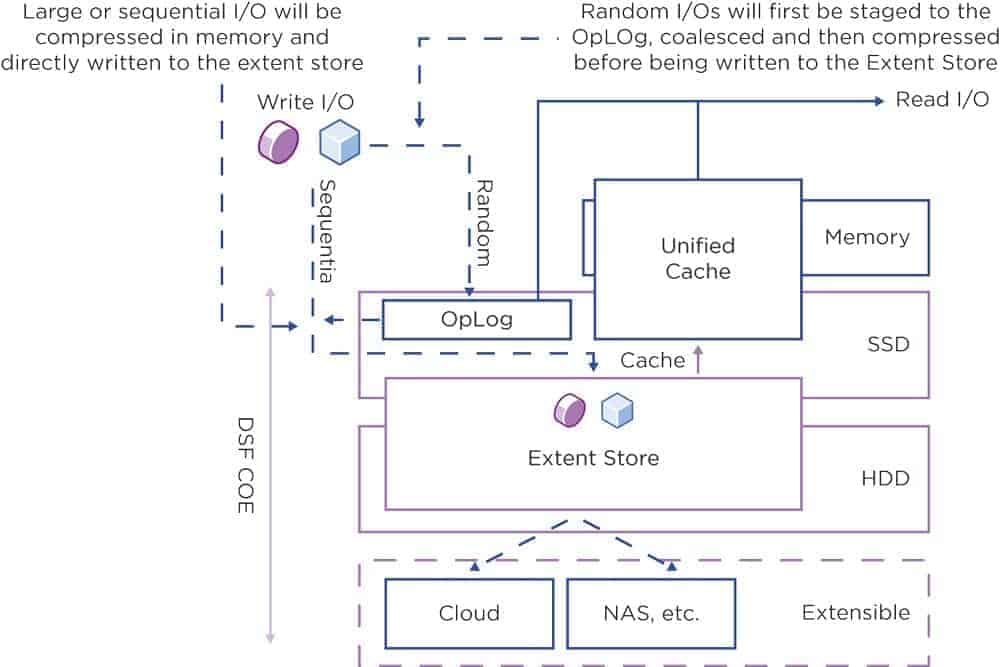

Si l'on veut esquisser le chemin d'entrée/sortie lors de l'accès aux données dans le DSF, on reconnaît trois domaines logiques : l'OpLog, l'Extent Store et le Content Cache (également appelé Unified Cache ; cf. illustration 2, page 48).

La zone OpLog se situe pour ainsi dire au-dessus du niveau de mémoire SSD et NVMe, l'Extent Store couvre une partie de la mémoire SSD ainsi que NVMe et une partie de la mémoire du disque dur. Le cache de contenu, quant à lui, se situe au-dessus du SSD ainsi que du NVMe et de la zone de mémoire vive.

La zone de l'OpLog agit comme un tampon d'écriture pour les tâches d'entrée/sortie (comparables à un journal de système de fichiers), qui sont par exemple émises par les VM sur un nœud. Ces tâches d'E/S sont donc stockées dans la zone de la mémoire basée sur le SSD.

Ces tâches d'écriture sont ainsi traitées à grande vitesse. De plus, elles sont également répliquées à partir d'OpLog sur d'autres nœuds d'un cluster. Cela garantit une disponibilité fiable des données - même si, par exemple, un nœud tombe complètement en panne.

La zone OpLog permet en outre d'accepter des tâches d'écriture aléatoire de type rafale et de les fusionner avec d'autres tâches d'écriture pour les transmettre ensuite de manière séquentielle à l'"Extent Store". Cette zone comprend la mémoire SSD, NVMe et disque dur, et c'est également là que toutes les actions de stockage sont effectuées.

Dans l'Extent Store se trouve l'ILM, l'Information Lifecycle Manager. Celui-ci est chargé de trouver l'espace de stockage optimal pour les données. Cette décision est prise en fonction du modèle d'action d'entrée/sortie et de la fréquence d'accès.

L'ILM place les données plus anciennes ou "refroidies", auxquelles on n'accède plus souvent, dans la zone du disque dur. Cela libère de l'espace au niveau du SSD et du NVMe, plus coûteux, où les données plus récentes - et plus "chaudes" - peuvent être conservées.

Mais il est également possible de contourner la zone OpLog. Cela a du sens lorsque les charges de travail accèdent à la mémoire avec un modèle d'accès séquentiel (donc pas de "Random IOs").

Ici, le regroupement de plusieurs tâches d'écriture n'apporterait aucune amélioration - c'est pourquoi l'écriture se fait directement sur l'Extent Store.

Dans le chemin de lecture, il faut avant tout mentionner le cache de contenu. Il stocke les données de manière dédupliquée - même si différentes VM accèdent aux mêmes données, le Content Store ne conserve donc qu'une seule instance de ces données.

De plus, le magasin de contenu se trouve en partie dans la mémoire vive et en partie dans la zone SSD et NVMe. Cela permet en général de satisfaire tous les accès en lecture aux données.

Si, lors d'une opération de lecture, les données ne se trouvent pas dans le cache de contenu, le système va les chercher dans l'Extent Store et donc, dans certains cas, sur les disques durs. Lors de chaque accès ultérieur à ces zones de données, l'accès en lecture est alors couvert par le cache de contenu.

La compression des données est une fonction de stockage importante. Nutanix utilise cette fonctionnalité pour augmenter l'efficacité des données sur les disques. Pour ce faire, la DSF propose à la fois la compression en ligne et la compression post-processus.

Il en résulte que la méthode optimale est appliquée en fonction des exigences des applications et des types de données : Dans l'approche en ligne, les flux de données séquentiels ou les grands blocs d'entrée/sortie sont comprimés dans la mémoire de travail avant d'être écrits sur les disques durs.

En revanche, lors de la compression post-processus, les données sont généralement stockées sans être comprimées. Ce n'est qu'ensuite que la structure curatrice du nœud Nutanix, basée sur l'algorithme MapReduce, se charge de la compression des données à l'échelle du cluster.

Lorsque la compression en ligne est utilisée pour des accès d'E/S aléatoires, le système écrit d'abord les données dans l'OpLog. Elles y sont regroupées puis compressées en mémoire vive avant d'être écrites dans l'Extent Store.

Résistance aux pannes

Le stockage redondant des données fait également partie des fonctions de stockage importantes : elles doivent être protégées contre la défaillance d'un nœud et donc être stockées sur plusieurs nœuds. Pour cela, Nutanix dispose du Replication Factor, en abrégé : RF, qui peut également être considéré comme un Resilience Factor.

Avec une somme de contrôle pour les données, la redondance des données et la haute disponibilité sont garanties même en cas de défaillance des nœuds ou des disques durs.

L'OpLog joue ici un rôle important en tant que tampon d'écriture persistant : il agit comme point de collecte pour tous les accès en écriture entrants sur la zone SSD, qui se caractérise par des temps d'accès réduits.

Lorsque des données sont écrites sur l'OpLog local d'un nœud, ces données peuvent être répliquées de manière synchrone vers un, deux ou trois autres OpLogs sur des CVM d'autres nœuds, en fonction de la valeur du RF. Les CVM sont les VM contrôleurs de Nutanix, un centre de contrôle du logiciel HCI.

Ce n'est que lorsqu'une confirmation d'écriture est reçue de ces OpLogs que l'accès en écriture est considéré comme ayant été effectué avec succès. De cette manière, on s'assure que les données existent au moins en deux ou plusieurs endroits indépendants. Au final, l'objectif de tolérance aux erreurs est ainsi atteint.

Le facteur de réplication pour les données est configuré à l'aide de la console d'administration Nutanix Prism. Tous les nœuds sont pris en compte dans la réplication OpLog, de sorte qu'il n'y a pas de nœuds "particulièrement chargés", c'est-à-dire que la charge d'écriture supplémentaire due à la réplication est répartie au mieux. Ainsi, la construction complète atteint également une échelle linéaire correspondante en ce qui concerne la performance d'écriture.

Lorsque les données sont écrites dans l'OpLog, le système calcule une somme de contrôle pour ces données et enregistre cette somme de contrôle dans les métadonnées. Ensuite, les données de l'OpLog sont envoyées de manière asynchrone dans l'Extent Store et y sont ensuite disponibles - répliquées en fonction du RF souhaité, car chaque OpLog écrit ses informations dans l'Extent Store.

Si un nœud ou même un disque tombe en panne, les données sont à nouveau répliquées entre les nœuds restants du cluster, de sorte que le RF souhaité soit à nouveau respecté.

Lors de l'accès en lecture à ces données, la somme de contrôle est calculée et comparée à la valeur enregistrée dans les métadonnées. Si la somme de contrôle ne correspond pas, les données sont lues par un autre nœud - pour lequel la somme de contrôle correspond aux données souhaitées. Ces données remplacent alors celles qui ne correspondent pas. On s'assure ainsi qu'il s'agit de données valides.

Stockage par niveaux

Une tâche importante du DSF est l'agrégation de la capacité de mémoire de tous les nœuds d'un cluster. L'espace de stockage complet est ainsi mis à la disposition de tous les nœuds. Ce "Disk Tiering" est rendu possible par des algorithmes spéciaux de "tiering".

Grâce à eux, les SSD et les disques durs d'un cluster sont disponibles pour tous les nœuds et la gestion du cycle de vie de l'information (ILM) de la DSF veille à ce que les données soient placées au niveau du SSD ou du disque dur, en fonction de la fréquence d'accès à ces données. Ces événements de stockage spéciaux sont déclenchés automatiquement et les données sont ensuite déplacées en conséquence.

Afin de respecter le principe de la localité des données lors de la hiérarchisation du stockage, la règle suivante s'applique : même si tous les disques SSD d'un cluster sont en principe disponibles pour tous les nœuds du réseau, la couche SSD du nœud local a néanmoins la priorité la plus élevée pour les opérations d'entrée/sortie locales.

Cette procédure est étendue lorsqu'un RF défini indique que les données doivent être stockées de manière hautement disponible, c'est-à-dire sur plusieurs nœuds. Comme la DSF regroupe tous les SSD et les disques durs en une couche de stockage à l'échelle du cluster, chaque nœud - local ou distant - dispose en principe de la capacité de stockage agrégée complète de cette mémoire logique. Toutes les actions dans le cadre de l'ILM se font en outre sans que l'administrateur doive explicitement exécuter des actions.

Grâce à cette technique, la DSF garantit une utilisation uniforme et efficace des périphériques de stockage dans le cadre des différentes couches. Si la zone SSD d'un nœud local est pleine, la DSF équilibre l'utilisation des appareils : Les données auxquelles on accède moins souvent sont déplacées du SSD local vers d'autres SSD du cluster.

Cela permet de libérer à nouveau de l'espace SSD sur le nœud local. Ainsi, le nœud local peut à nouveau écrire sur les SSD locaux et ne doit pas passer par le réseau pour accéder à la zone SSD d'un autre nœud. Toutes les machines virtuelles du contrôleur et les disques SSD supportent les opérations d'entrée/sortie à distance.

Cela permet d'éviter les goulets d'étranglement et de ne pas être désavantagé lorsque les opérations d'entrée/sortie doivent être effectuées via le réseau.

Puissance

L'architecture et la technologie Nutanix permettent d'atteindre les plus hautes performances, même dans un environnement SAP entièrement virtualisé, et ce dans sa globalité. En effet, selon SAP, ce ne sont pas les paramètres individuels qui comptent, mais la performance globale.

La société de Walldorf les mesure dans une unité standardisée, appelée SAP Application Performance Standard (SAPS). Cette unité est une mesure indépendante du matériel. Elle décrit la performance d'une configuration système dans un environnement SAP et est dérivée du Sales and Distribution Benchmark.

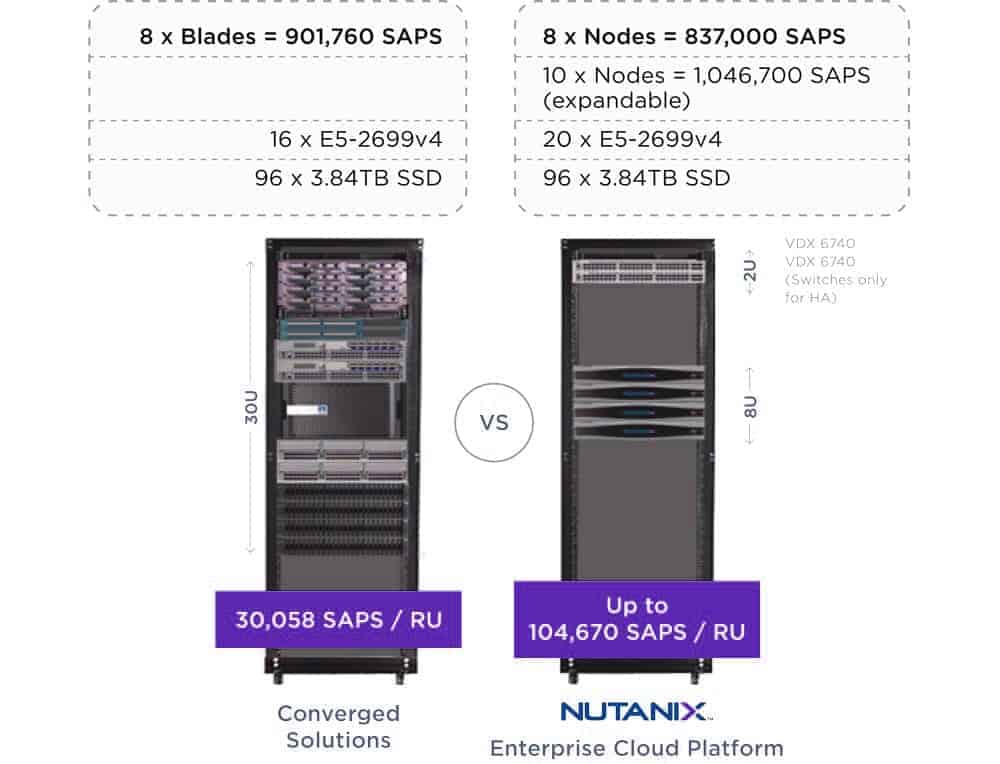

Selon ce benchmark, 100 SAPS sont définis comme 2000 positions de commande qui sont entièrement traitées en une heure. Pour illustrer la performance d'un environnement SAP entièrement virtualisé basé sur Nutanix par rapport aux options d'implémentation traditionnelles, la densité de performance dérivée de l'unité SAPS est un bon exemple :

Par exemple, les nœuds hyperconvergés Nutanix permettent d'obtenir 104 670 SAPS par unité de hauteur de rack, alors qu'une solution convergente dotée de ressources de calcul et de stockage comparables permet d'obtenir 30 058 SAPS par unité de hauteur.

En d'autres termes, pour obtenir les mêmes performances, un environnement SAP entièrement virtualisé basé sur Nutanix ne nécessite qu'un tiers de l'espace disponible dans le centre de données (voir figure 3, ci-dessous). Au vu des caractéristiques du logiciel d'infrastructure de Nutanix, qui sont loin d'être exhaustives, les doutes concernant les environnements SAP virtualisés ne semblent plus justifiés.

Cette constatation donne aux décideurs SAP la liberté d'orienter leur infrastructure strictement en fonction de critères commerciaux. Des coûts d'infrastructure réduits jusqu'à 60%, des besoins en électricité et en refroidissement réduits jusqu'à 90%, une réduction radicale de la charge administrative grâce à l'automatisation, une plus grande liberté dans le choix des offres de matériel et la compatibilité avec les piles de cloud public courantes pour les scénarios hybrides, etc. sont autant d'avantages importants qui ne peuvent être obtenus que de manière très limitée avec les infrastructures traditionnelles.

Les environnements SAP virtualisés basés sur le logiciel HCI de Nutanix permettent non seulement de réaliser des économies à court terme, mais aussi de réduire le coût total de possession des environnements SAP actuels et futurs et de faciliter le passage à la nouvelle génération de produits de Walldorf.

Valpak, client de Nutanix

Valpak accélère ses activités traditionnelles et en ligne

Après le rachat de Savings.com par Valpak, la société de conformité britannique avait besoin d'une infrastructure plus simple et plus rentable pour prendre en charge des charges de travail telles que SAP, Oracle et SQL Server. En même temps, l'équipe informatique ne devait pas trop s'agrandir et devenir plus agile, sans que cela ne se fasse au détriment de la stabilité. En outre, les performances devaient augmenter. En utilisant le logiciel d'infrastructure de Nutanix, Valpak :

- accélérer ses déploiements d'un facteur 10

- augmenter les performances d'un facteur 8

- réduire la charge administrative de 180 heures par mois à 2 heures seulement

- diviser par dix ses dépenses d'investissement et, depuis, faire croître son infrastructure informatique en fonction de ses besoins

ASM, client de Nutanix

ASM génère des rapports par lots 5 fois plus rapidement qu'auparavant

ASM International, dont le siège se trouve aux Pays-Bas, est un fournisseur leader d'installations pour la fabrication de wafers dans l'industrie des semi-conducteurs. ASM cherchait à remplacer son infrastructure vieillissante afin de remplacer le traitement par lots lent par un traitement plus rapide. De plus, l'équipe d'exploitation informatique devait être soulagée des problèmes constants avec le matériel qui supporte des applications aussi diverses que SAP ERP, CRM, SCM, PI, BW, BOBJ, PLM, SRM, PORTAL, etc. Avec l'aide de Nutanix Enterprise Cloud, ASM :

- multiplié par 5 la vitesse de traitement par lots afin de répondre aux exigences croissantes du marché

- réduit de près d'un tiers le temps nécessaire à son fonctionnement

- a amélioré son environnement système de 50 % à 500 %, selon les domaines

- consolidé les machines virtuelles pour SAP et les bases de données, économisant ainsi les coûts de licence

Client Nutanix : multinationale de l'industrie alimentaire

Une multinationale de l'agroalimentaire modernise son environnement SAP

Une entreprise alimentaire connue cherchait des moyens de réaliser de nouveaux projets commerciaux plus rapidement qu'auparavant. Le temps nécessaire aux nouveaux déploiements sur l'infrastructure existante avec des charges de travail telles que Electronic Data Interchange (B2BI), Order-to-Cash (SAP NetWeaver et B2BI), SAP Project Staging (CRM, applications BW) et autres applications était cependant trop important. Les objectifs commerciaux de plus en plus ambitieux ne pouvaient donc plus être atteints. En outre, l'entreprise souffrait d'un manque d'espace dans ses centres de données, devait maîtriser les coûts de stockage courants et cherchait une solution qui lui permettrait de démarrer immédiatement la mise en œuvre de sa stratégie de cloud. L'équipe informatique a entrepris de reconstruire son énorme environnement UNIX en utilisant des serveurs Linux virtualisés fonctionnant sur Nutanix Enterprise Cloud. Les résultats ne se sont pas fait attendre :

- 40% de moins

- Coût total de possession (TCO)

- réduction massive de la

- Total des empreintes

- suppression sans remplacement de la

- Infrastructure SAN

- mise en œuvre et distribution plus agiles de nouveaux déploiements

- allégé

- Processus de mise à niveau

- une claire

- Feuille de route du cloud