Intelligence artificielle : le pas de l'idée à la production

Ce n'est un secret pour personne : toutes les entreprises du monde entier s'efforcent d'exploiter le potentiel de l'IA, et notamment de l'IA générative. Les entreprises savent que l'IA peut améliorer leur efficacité, réduire les coûts, améliorer la satisfaction des clients et des employés, créer un avantage concurrentiel et automatiser les processus commerciaux. Tout cela est possible car la technologie est de plus en plus disponible et accessible aux entreprises de toutes tailles. Grâce à de nombreuses options de déploiement et à différentes combinaisons de matériel et de logiciels, l'accès aux technologies d'IA et de ML est devenu plus facile.

Les entreprises n'ont plus besoin d'un déploiement complet de l'IA/ML pour utiliser certaines fonctions telles que les services d'IA basés sur le cloud ou les outils commerciaux basés sur l'IA. Par conséquent, des investissements croissants dans les technologies d'IA se profilent à l'horizon. Toutefois, le marché de l'IA est actuellement très fragmenté. Dans ce contexte, les entreprises ont souvent du mal à choisir la bonne voie. Elles sont surtout confrontées au défi d'introduire des modèles d'IA dans la production de manière efficace et sûre. Même les entreprises qui ont mené à bien leurs premiers projets d'IA hésitent ou échouent dans leur transformation à grande échelle. Il y a de nombreuses raisons à cela.

De nombreuses entreprises craignent un verrouillage des fournisseurs et voient les dangers et les risques de la technologie de l'IA. Pour d'autres, l'adaptation des modèles d'IA en fonction des besoins est une tâche difficile à réaliser. Face à ces défis, de nombreux projets d'IA restent bloqués au stade du pilote ou de la preuve de concept.

L'approche de Red Hat en matière d'ingénierie IA et ML est 100 % open source.

Le bon modèle d'IA

Seule une approche stratégique qui soulève des questions élémentaires et y répond avant même l'introduction de l'IA peut garantir le succès. Cela implique avant tout de choisir les bons modèles d'IA et la plateforme ou la base d'infrastructure adéquate.

Lorsqu'il s'agit de choisir un modèle d'IA particulier, une tendance claire se dégage. De plus en plus d'entreprises ne misent pas sur des LLM, mais sur des modèles plus petits, conçus pour des cas d'utilisation spécifiques. Le problème de l'utilisation de modèles plus grands - avec des milliards de paramètres - est que, bien qu'ils possèdent des connaissances génériques étendues, ils ne sont pas très utiles lorsqu'une entreprise souhaite créer un chatbot pour ses représentants du service clientèle ou aider les clients à résoudre un problème concret avec un produit ou un service. Par rapport aux LLM, les petits modèles présentent de nombreux avantages. Ils sont plus faciles à mettre en œuvre et permettent une intégration continue de nouvelles données, notamment celles spécifiques à l'entreprise et au domaine. En d'autres termes, ils permettent également de réaliser des exercices d'entraînement beaucoup plus rapidement.

Les modèles contribuent également à une réduction considérable des coûts, car les grands LLM nécessitent des investissements importants. Enfin, en utilisant des modèles plus petits, les entreprises peuvent également réduire leur dépendance vis-à-vis des grands fournisseurs de LLM, dont les solutions constituent souvent une boîte noire en termes d'algorithmes, de données d'entraînement ou de modèles. De manière générale, la tendance actuelle dans le secteur est de fournir des modèles d'IA plus petits et optimisés. L'approche vLLM (Virtual Large Language Model) en est un exemple. Elle permet d'accélérer les calculs avec un serveur d'inférence, par exemple en utilisant plus efficacement la mémoire du GPU.

Projet InstructLab

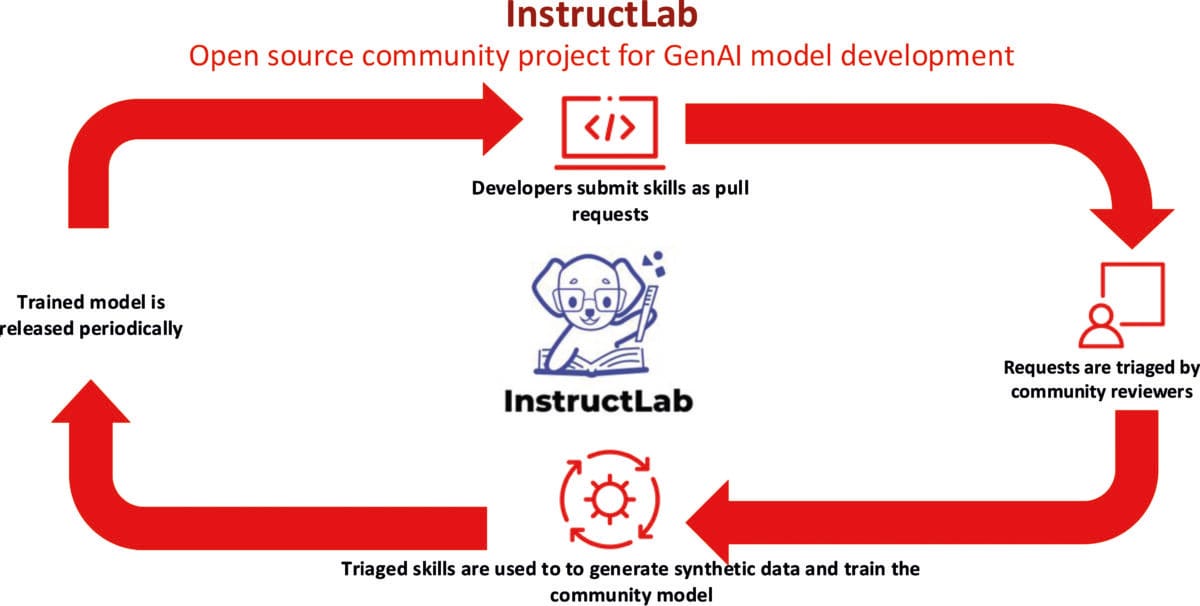

Mais même les LLM génériques, qui présentent différents degrés d'ouverture en termes de données de préformation et de restrictions d'utilisation, peuvent désormais être améliorés pour un objectif commercial spécifique. À cet effet, Red Hat et IBM ont lancé le projet communautaire InstructLab, qui fournit une solution rentable pour améliorer les LLM. Cette solution nécessite beaucoup moins de données et de ressources de calcul pour la reformation d'un modèle. InstructLab réduit considérablement l'obstacle à l'entrée dans le développement de modèles d'IA, même pour les utilisateurs qui ne sont pas des data scientists.

InstructLab permet à des experts du domaine issus de différents domaines d'apporter leurs connaissances et leur savoir et de développer ainsi un modèle d'IA open source accessible à tous. Il est également possible d'optimiser davantage un modèle convenu avec InstructLab par l'application de la technique RAG (Retrieval-Augmented Generation). RAG offre en général la possibilité de compléter les données disponibles dans un LLM par des sources de connaissances externes avec des données actuelles en temps réel, des informations contextuelles, propriétaires ou spécifiques à un domaine, par exemple des référentiels de données ou des documentations existantes. Cela permet également de s'assurer beaucoup plus facilement que les modèles fournissent des réponses correctes et sûres, sans halluciner.

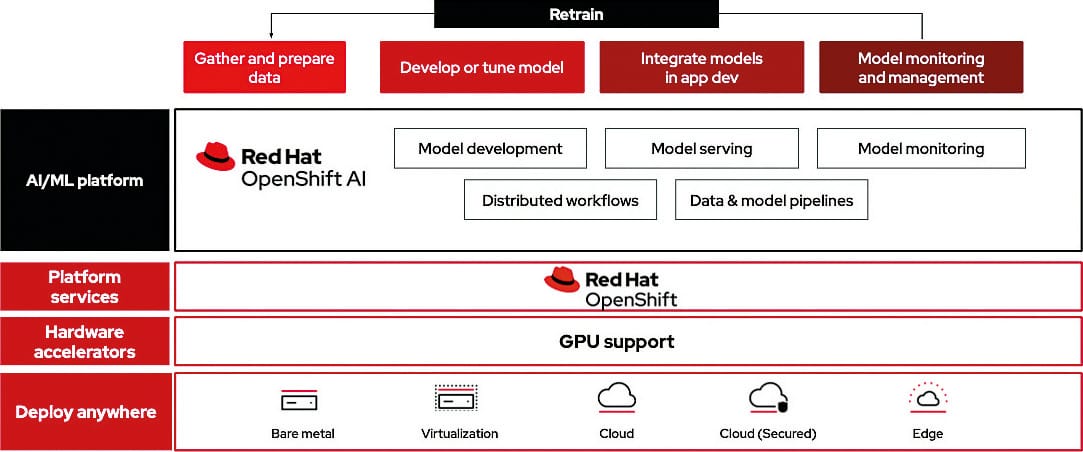

Red Hat OpenShift AI, une plate-forme IA/ML flexible et évolutive, permet aux entreprises de développer et de déployer des applications basées sur l'IA dans des environnements de cloud hybride.

IA open source

Il ne fait aucun doute que les entreprises doivent s'intéresser de plus en plus à de nouveaux thèmes tels que l'IA et le ML afin d'assurer leur compétitivité et leur pérennité. Une utilisation sans réserve et sans esprit critique n'est toutefois pas justifiable. La sécurité, la stabilité et la souveraineté numérique doivent toujours être garanties.

En ce qui concerne la souveraineté, il s'agit avant tout de la technologie, de l'exploitation et des données. Les entreprises devraient veiller à l'indépendance des fournisseurs, tant en ce qui concerne le choix entre les composants propriétaires et open source qu'en ce qui concerne les options de déploiement flexibles. La souveraineté des données signifie que les entreprises savent à quel endroit et avec quelle méthode leurs propres données sont stockées et traitées.

Dans le contexte de ces exigences de souveraineté, les principes, technologies et solutions open source transparents gagnent en importance. En particulier lorsque l'IA est utilisée dans des domaines critiques pour l'entreprise, un haut niveau de traçabilité et d'explicabilité doit toujours être garanti. Les entreprises ne veulent pas une boîte noire, mais une IA digne de confiance et explicable, qui respecte les principes juridiques et éthiques. C'est justement lors de la mise en œuvre que l'on voit à nouveau la valeur des procédures open source qui ont fait leurs preuves et qui, comme auparavant dans le domaine du développement de logiciels, sont synonymes de grande transparence.

Toutefois, dans le domaine de l'IA, comme dans le développement de logiciels en général, il existe un risque de blanchiment de l'open source, comme le montre une comparaison des éléments clés des logiciels open source et des LLM open source. Les logiciels open source se caractérisent par une transparence totale, des algorithmes compréhensibles, un traitement des erreurs visible et la possibilité de faire avancer le développement avec la participation de la communauté. En revanche, de nombreux LLM dits open source se caractérisent certes en général par une libre disponibilité, mais ils n'offrent guère de visibilité sur des aspects comparables au développement de logiciels, tels que les données d'entraînement, les pondérations, les garde-fous internes au modèle ou une feuille de route solide.

Du point de vue de l'entreprise, la traçabilité et la base de données sont toutefois d'une importance fondamentale, ne serait-ce que pour des raisons de responsabilité ou de conformité. Une IA digne de confiance est également souvent indispensable en raison des exigences réglementaires élevées qui découlent par exemple du RGPD ou de l'AI Act de l'UE. Une approche open source est la bonne base pour cela, car elle offre transparence, innovation et sécurité. Il faut toutefois qu'elle soit véritablement open source et qu'elle réponde aux critères centraux de l'open source - également en ce qui concerne les données d'entraînement ou les modèles d'IA - et pas seulement à l'open source washing.

La bonne plate-forme

Quelle que soit la voie choisie par l'entreprise - utilisation d'un LLM ou de plusieurs modèles plus petits -, la plateforme de l'IA est essentielle : La plateforme utilisée est toujours un élément important de l'environnement d'IA. De nombreuses entreprises continuent de miser sur leurs propres infrastructures et serveurs sur site. Cette approche limite toutefois la flexibilité nécessaire pour introduire des technologies innovantes telles que l'IA. Le marché du cloud a toutefois évolué entre-temps et offre le meilleur des deux mondes : le cloud hybride. Il permet aux entreprises de continuer à utiliser le stockage sur site pour les données sensibles tout en profitant des avantages d'évolutivité du cloud public.

InstructLab est un projet open source visant à améliorer les LLM. Lancé par IBM et Red Hat, ce projet communautaire permet de simplifier l'expérimentation de modèles d'intelligence artificielle générative et d'optimiser l'adaptation des modèles.

Cloud hybride pour l'IA

Une plateforme de cloud hybride constitue donc également une base d'infrastructure idéale pour la mise en œuvre sécurisée de l'IA, du développement de modèles d'IA à l'intégration de modèles d'IA dans des applications, en passant par la formation de modèles d'IA et l'exploitation de services MCP (Model Context Protocol) et A2A (Agent to Agent) modernes. Le cloud hybride offre la flexibilité nécessaire pour choisir le meilleur environnement pour chaque charge de travail d'IA. Les entreprises ont deux possibilités d'utilisation. Elles peuvent développer et entraîner un modèle d'IA dans un cloud public sur des fermes de GPU avec une séparation claire des clients, y compris en utilisant des données disponibles publiquement et des données de test synthétiques, puis l'intégrer dans l'application sur site. Enfin, il faut également tenir compte du fait que la mise en place d'une infrastructure GPU propre et coûteuse n'est généralement pas possible pour les entreprises. Mais à l'inverse, elles peuvent aussi entraîner les modèles avec des données confidentielles dans leur propre centre de calcul et les exploiter ensuite dans un cloud public.

Les fonctionnalités MLOps (Machine Learning Operations) constituent un élément important d'une plateforme conçue pour l'utilisation de l'IA. MLOps ressemble au concept DevOps bien établi, mais l'accent est mis sur le déploiement, la maintenance et la rééducation des modèles d'apprentissage automatique. MLOps contribue avant tout à une collaboration efficace et optimisée entre les équipes de science des données, de développement logiciel et d'exploitation. Cela permet de faire le lien entre le développement des modèles ML et leur utilisation dans un environnement de production. Les pratiques MLOps, qui visent la simplification, l'automatisation et la mise à l'échelle, contribuent donc également à accélérer considérablement le déploiement en production.

Pour réduire la complexité opérationnelle, une plateforme doit également offrir des outils avancés pour l'automatisation des déploiements et un accès en libre-service aux modèles et aux ressources. Les entreprises peuvent ainsi gérer et faire évoluer elles-mêmes leurs environnements de formation et de déploiement de modèles en fonction de leurs besoins. Il est également important de disposer d'outils IA/ML testés et pris en charge.

Enfin, une approche par plateforme garantit que les partenaires industriels, les clients et la vaste communauté open source peuvent coopérer efficacement pour faire progresser l'innovation en matière d'IA open source. Il existe un immense potentiel pour élargir cette collaboration ouverte dans le domaine de l'IA, notamment en ce qui concerne le travail transparent sur les modèles et leur formation.

Utilisation de l'IA en production

Le monde de l'IA peut ainsi s'ouvrir davantage et se démocratiser. Pour les utilisateurs de l'IA, l'ouverture de la plateforme à un réseau de partenaires matériels et logiciels présente un avantage central : ils obtiennent la flexibilité dont ils ont besoin pour mettre en œuvre leurs cas d'utilisation spécifiques. De telles plateformes flexibles et hybrides pour l'utilisation de l'IA en production sont désormais disponibles, comme le montre l'exemple de Red Hat OpenShift AI. Elles permettent à une entreprise d'exclure tout verrouillage par le fournisseur, de suivre les nouvelles innovations en matière d'IA et de mettre en œuvre tous les cas d'utilisation possibles. Elle prend en charge la formation et le réglage fin des modèles ainsi que le déploiement et la surveillance de tous les modèles et applications d'IA, dans le cloud, en périphérie et sur site. La flexibilité et la compatibilité sont assurées par une structure modulaire et une fonctionnalité plug-and-play avec des composants open source et d'autres solutions d'IA. Avec une telle base de solutions, les entreprises peuvent faire progresser l'introduction de l'IA de manière successive et simple, ce qui leur permet également de maîtriser les coûts.

De nombreuses entreprises se trouvent encore dans une phase d'évaluation ou de preuve de concept lors de l'introduction de l'IA. Même si l'on parle beaucoup de grands modèles de langage et d'IA générative, il ne faut pas oublier une chose : Le passage de l'IA à grande échelle à l'environnement de production est certes un thème plutôt nouveau, mais il ne concerne en aucun cas uniquement les LLM, mais aussi, par exemple, l'IA prédictive ou analytique. Ici aussi, il y a des défis qui ne peuvent être relevés de manière judicieuse qu'avec une approche de plateforme.

Continuer vers l'inscription du partenaire :