Virtualización SAP - Una mirada bajo el capó

![[shutterstock.com: 725365669, Gorodenkoff]](https://e3mag.com/wp-content/uploads/2020/07/shutterstock_725365669.jpg)

Las ventajas de la virtualización en el entorno SAP son bien conocidas. La reducción de costes, los ciclos de lanzamiento más cortos, la mayor flexibilidad y la posibilidad de clonar incluso grandes sistemas SAP en cuestión de minutos para preparar y aplicar actualizaciones, etc., son argumentos básicamente imbatibles.

Y, sin embargo, muchos propietarios de aplicaciones dudan de su importancia, ya que se centran principalmente en los datos de rendimiento durante el funcionamiento y la protección contra la pérdida de datos.

Y no se equivocan al hacerlo, porque, al fin y al cabo, es crucial que los usuarios puedan trabajar de forma productiva con las distintas aplicaciones de SAP y cumplir sus tareas empresariales.

Por tanto, un entorno SAP virtualizado debe demostrar que las preocupaciones de los gestores de aplicaciones son infundadas. Esto también se aplica a los sistemas SAP, incluidos los entornos Hana, S/4 y NetWeaver, que se basan en el software HCI de Nutanix.

Por tanto, merece la pena echar un vistazo "bajo el capó", por así decirlo, para comprender mejor que las ventajas de los entornos SAP virtualizados descritas anteriormente no van en detrimento del rendimiento durante el funcionamiento.

En el software de Nutanix, se puede operar cualquier combinación de aplicaciones en su propio centro de datos y éstas también se pueden escalar a dimensiones que, de otro modo, sólo son posibles cuando se opera en una nube pública.

La plataforma ofrece valores muy altos en términos de rendimiento de entrada/salida (medido en IOPS, es decir, operaciones de entrada/salida por segundo) y, al mismo tiempo, sólo retrasos muy bajos en los tiempos de respuesta.

Las mediciones realizadas en Nutanix han demostrado que es mejor aumentar el número de máquinas virtuales (VM) con bases de datos para aprovechar al máximo el rendimiento de la plataforma, en lugar de desplegar un gran número de instancias de bases de datos en una única VM.

En términos de rendimiento de entrada/salida, Nutanix ofrece los valores de rendimiento y los requisitos de transacción necesarios incluso para bases de datos analíticas y de transacciones muy complejas, incluida Hana, a través de su "Distributed Storage Fabric" (DSF).

Escalado y localización de datos

Toda la arquitectura de la infraestructura de software hiperconvergente de Nutanix sigue un enfoque de "escala web" (véase la Figura 1, página 47): Se utilizan nodos con una potencia de cálculo muy elevada, es decir, servidores. En los nodos operan hipervisores estándar.

Entre ellos se incluyen vSphere/ESXi de VMware, Hyper-V de Microsoft o el hipervisor AHV de Nutanix certificado para NetWeaver, Hana y S/4. El hardware de un nodo de este tipo consta de procesadores, RAM y componentes de almacenamiento local -pueden ser unidades SSD basadas en flash y/o discos duros SATA, así como almacenamiento NVMe con altas capacidades de almacenamiento-.

Las máquinas virtuales se ejecutan en cada uno de estos nodos, al igual que un sistema host estándar para máquinas virtuales. Sin embargo, también se utiliza una VM de control para cada nodo, que proporciona todas las funciones relevantes para Nutanix.

Esta capa intermedia forma el DSF y, por tanto, es responsable de garantizar que todos los componentes de almacenamiento local se pongan a disposición de todos los nodos en forma de pool normalizado, por así decirlo.

También puedes pensar en el DSF como una especie de dispositivo de almacenamiento virtual que ofrece los SSDs y discos duros locales a todos los nodos (a través del protocolo NFS o SMB) para almacenar los datos de las distintas VMs. Las máquinas virtuales individuales de un clúster escriben los datos en el DSF como si fuera un dispositivo de almacenamiento compartido normal.

El DSF cumple aquí una tarea importante: siempre almacena los datos lo más "cerca" posible de la VM en cuestión. Esto se consigue almacenando los datos lo más localmente posible: si una VM se está ejecutando en el nodo A, los datos asociados de esta VM normalmente también se almacenan en el nodo A.

El resultado es que se consigue la mayor velocidad posible de acceso a los datos sin elevados costes para los componentes de almacenamiento.

Este principio de localización de los datos se complementa con un almacenamiento redundante de los mismos si se desea que estén altamente disponibles, por lo que se almacenan en varios nodos.

Gracias a este concepto, la infraestructura basada en el software HCI de Nutanix escala linealmente desde una configuración con sólo tres nodos hasta cualquier número de nodos.

Esto ofrece grandes ventajas a las empresas, ya que añadiendo más nodos se puede ampliar enormemente la red con sólo unos clics, sin tener que pensar en conectar los nodos entre sí.

DSF también ofrece una serie de importantes funciones de gestión de datos, como el "agrupamiento de datos por niveles" a nivel de clúster, en el que los datos se reubican automáticamente en dispositivos de almacenamiento más rápidos o más lentos en función de la frecuencia de acceso: "datos calientes" frente a "datos fríos".

Flujo de datos y funciones de memoria

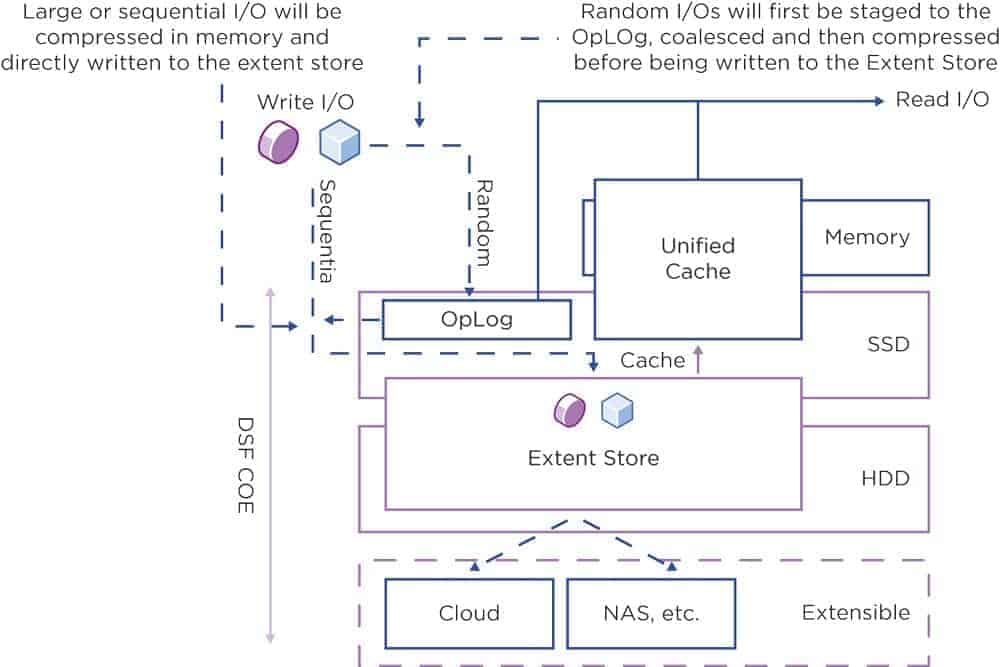

Si quieres esbozar la ruta de entrada/salida al acceder a los datos en el DSF, reconocerás tres áreas lógicas: el OpLog, el Extent Store y la Caché de Contenido (también conocida como Caché Unificada; ver Figura 2, página 48).

El área OpLog se encuentra por encima del nivel de almacenamiento SSD y NVMe, por así decirlo, mientras que el almacén de alcance cubre parte del SSD y NVMe y parte del almacenamiento del disco duro. La caché de contenido, por su parte, se encuentra por encima de las áreas SSD, NVMe y RAM.

El área OpLog actúa como un búfer de escritura para los trabajos de entrada/salida (comparable a un diario del sistema de archivos) que son emitidos por las máquinas virtuales en un nodo, por ejemplo. Por lo tanto, estos trabajos de E/S se almacenan en el área de memoria basada en SSD.

Esto significa que estos trabajos de escritura se procesan a gran velocidad. También se replican desde el OpLog a otros nodos de un clúster. Esto garantiza una disponibilidad fiable de los datos, incluso si un nodo falla por completo, por ejemplo.

El área OpLog también permite aceptar solicitudes de escritura aleatoria de tipo ráfaga y fusionarlas con otras solicitudes de escritura para, a continuación, transferirlas secuencialmente al "Extent Store". Esta área incluye almacenamiento SSD, NVMe y de disco duro, y todas las acciones de almacenamiento también se ejecutan aquí.

El Extent Store contiene el ILM, el Gestor del Ciclo de Vida de la Información. Se encarga de encontrar el espacio de almacenamiento óptimo para los datos. Esta decisión se toma en función del patrón de acción de entrada/salida y de la frecuencia de acceso.

El ILM almacena los datos más antiguos o "fríos" a los que ya no se accede con frecuencia en la zona del disco duro. Esto libera espacio en el nivel más caro de SSD y NVMe, donde pueden almacenarse datos más nuevos y "calientes".

Sin embargo, el área OpLog también puede omitirse. Esto tiene sentido si las cargas de trabajo con un patrón de acceso secuencial (es decir, sin "IOs aleatorias") acceden a la memoria.

La combinación de varias tareas de escritura no aportaría ninguna mejora en este caso, por lo que la escritura se realiza directamente en el almacén de extensión.

En la ruta de lectura, destaca la caché de contenidos. Almacena los datos de forma deduplicada: incluso si diferentes máquinas virtuales acceden a los mismos datos, el almacén de contenidos sólo contiene una instancia de estos datos.

Además, el almacén de contenidos se encuentra en parte en la memoria principal y en parte en la zona SSD y NVMe. Esto significa que normalmente se pueden cumplir todos los accesos de lectura a los datos.

Sin embargo, si los datos no están en la caché de contenido durante una operación de lectura, el sistema los recupera del almacén de extensión y, por tanto, posiblemente de los discos duros. Sin embargo, con cada acceso posterior a estas áreas de datos, el acceso de lectura queda cubierto por la caché de contenido.

La compresión de datos es una importante función de almacenamiento. Nutanix utiliza esta funcionalidad para aumentar la eficiencia de los datos en las unidades. DSF ofrece compresión en línea y posterior al proceso.

Esto significa que se utiliza el método óptimo en función de los requisitos de las aplicaciones y los tipos de datos: Con el método en línea, los flujos de datos secuenciales o los grandes bloques de entrada/salida se comprimen en la memoria principal antes de escribirse en los discos duros.

En cambio, con la compresión posterior al proceso, los datos suelen almacenarse inicialmente sin comprimir. Solo entonces el marco curador del nodo Nutanix, que se basa en el algoritmo MapReduce, se encarga de la compresión de datos en todo el clúster.

Si se utiliza la compresión en línea para accesos de escritura de E/S aleatorios, el sistema escribe primero los datos en el OpLog. Allí se resumen y se comprimen en la memoria de trabajo antes de escribirse en el almacén de extensión.

Fiabilidad

Otra función importante del almacenamiento es el almacenamiento redundante de los datos: deben protegerse contra el fallo de un nodo y, por tanto, almacenarse en varios nodos. Nutanix cuenta con el factor de replicación, o RF para abreviar, que también puede entenderse como factor de resiliencia.

Junto con una suma de comprobación de los datos, esto garantiza la redundancia de los datos y una alta disponibilidad incluso si fallan los nodos o los discos duros.

El OpLog desempeña aquí un papel importante como búfer de escritura persistente: actúa como punto de recogida de todos los accesos de escritura entrantes al área SSD, que se caracteriza por tiempos de acceso cortos.

Cuando se escriben datos en el OpLog local de un nodo, estos datos pueden replicarse de forma sincrónica a uno, dos o tres OpLogs en CVMs de otros nodos, dependiendo de lo alta que esté configurada la RF. Las CVM son las VM controladoras de Nutanix, un centro de control del software HCI.

Sólo cuando se recibe una confirmación de escritura de estos OpLogs se considera que el acceso de escritura se ha completado con éxito. Esto garantiza que los datos estén disponibles en al menos dos o más ubicaciones independientes. Como resultado, se consigue el objetivo de tolerancia a fallos.

El factor de replicación de los datos se configura mediante la consola de gestión Nutanix Prism. Todos los nodos se incluyen en la replicación OpLog para que no haya nodos "especialmente cargados", es decir, la carga de escritura adicional debida a la replicación se distribuye de la mejor manera posible. Esto significa que toda la construcción también logra el correspondiente escalado lineal en términos de rendimiento de escritura.

Cuando los datos se escriben en el OpLog, el sistema calcula una suma de comprobación para estos datos y guarda esta suma de comprobación en los metadatos. A continuación, los datos del OpLog se envían de forma asíncrona al extent store y están disponibles allí, replicados tantas veces como sea necesario en función de la RF deseada, ya que cada OpLog escribe su información en el extent store.

Si falla un nodo o incluso un solo disco, los datos se replican de nuevo entre los nodos restantes del clúster para que vuelva a mantenerse la RF deseada.

Cuando se leen estos datos, se calcula la suma de comprobación y se compara con el valor almacenado en los metadatos. Si la suma de comprobación no coincide, los datos se leen desde otro nodo, donde la suma de comprobación coincide con los datos deseados. Estos datos sustituyen a los que no coinciden. Así se garantiza la validez de los datos.

Almacenamiento por niveles

Una tarea importante del DSF es agregar la capacidad de memoria de todos los nodos de un clúster. Toda el área de almacenamiento se pone a disposición de todos los nodos. Esta "jerarquización de discos" es posible gracias a algoritmos especiales de "jerarquización".

Con su ayuda, las unidades SSD y los discos duros de un clúster están a disposición de todos los nodos, y la gestión del ciclo de vida de la información (ILM) de DSF garantiza que los datos se almacenan en la unidad SSD o en el disco duro, en función de la frecuencia con que se acceda a ellos. Estos eventos especiales de almacenamiento se activan automáticamente y los datos se mueven en consecuencia.

Para cumplir el principio de localidad de los datos en el almacenamiento por niveles, se aplica lo siguiente: aunque todas las unidades SSD de un clúster estén en principio disponibles para todos los nodos de la red, la capa SSD del nodo local tiene la máxima prioridad para las operaciones locales de entrada/salida.

Este procedimiento se amplía si una RF definida especifica que los datos deben almacenarse con alta disponibilidad, es decir, en varios nodos. Como el DSF combina todas las unidades SSD y de disco duro en una capa de almacenamiento para todo el clúster, toda la capacidad de almacenamiento agregada de este almacenamiento lógico está disponible para cada nodo, ya sea local o remoto. Todas las acciones en el curso de ILM también tienen lugar sin que el administrador tenga que realizar ninguna acción explícita.

Con esta tecnología, DSF garantiza que los dispositivos de almacenamiento se utilicen de manera uniforme y eficiente dentro de los distintos niveles. Si el área SSD de un nodo local está llena, DSF equilibra la utilización del dispositivo: Los datos a los que se accede con menos frecuencia se trasladan del SSD local a otros SSD del clúster.

Esto libera espacio SSD en el nodo local. Esto significa que el nodo local puede volver a escribir en las unidades SSD locales y no tiene que acceder al área SSD de otro nodo a través de la red. Todas las VM controladoras y las SSD admiten operaciones de entrada/salida remotas.

Así se evitan cuellos de botella y se evitan inconvenientes si las operaciones de entrada/salida tienen que realizarse a través de la red.

Rendimiento

Gracias a la arquitectura y la tecnología de Nutanix, también se pueden conseguir los datos de mayor rendimiento en un entorno SAP completamente virtualizado, y en su totalidad. Y es que, según SAP, no se trata de parámetros individuales, sino del rendimiento global.

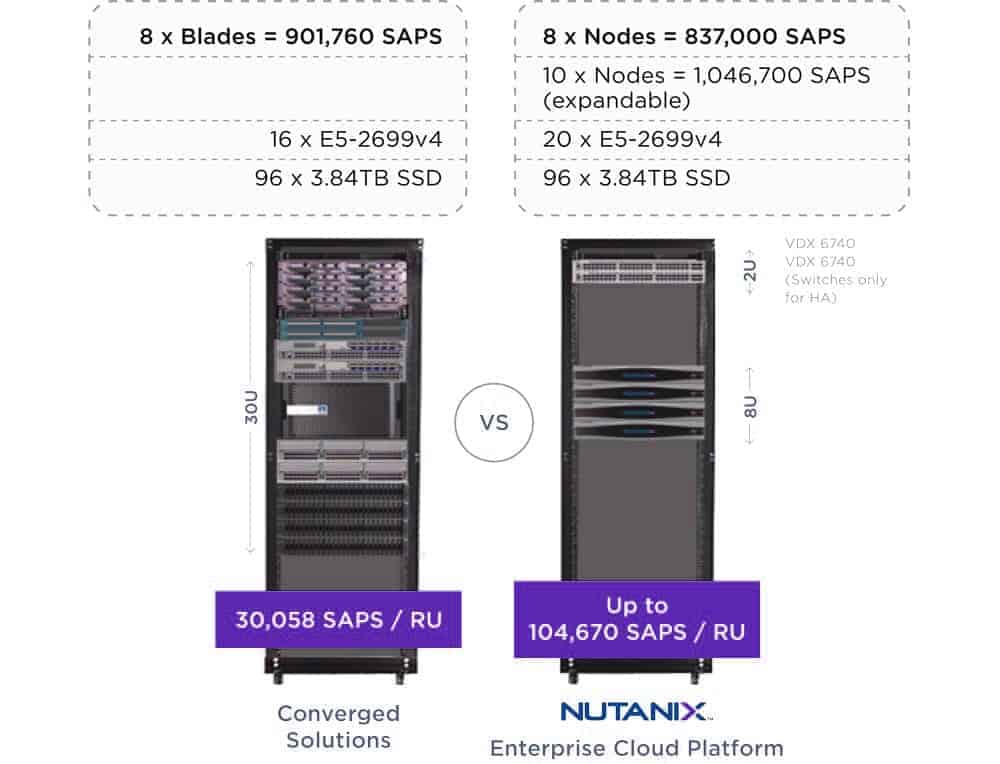

La empresa de Walldorf lo mide en una unidad normalizada conocida como SAP Application Performance Standard (SAPS). Esta unidad es una métrica independiente del hardware. Describe el rendimiento de una configuración de sistema en un entorno SAP y se deriva de la referencia de ventas y distribución.

Según este punto de referencia, 100 SAPS se definen como 2000 elementos de pedido que se procesan completamente en una hora. La densidad de rendimiento derivada de la unidad SAPS puede utilizarse para ilustrar el rendimiento de un entorno SAP totalmente virtualizado basado en Nutanix en comparación con las opciones de implementación convencionales:

Por ejemplo, los nodos hiperconvergentes de Nutanix pueden alcanzar 104.670 SAPS por unidad de rack, mientras que una solución convergente equipada con recursos informáticos y de almacenamiento comparables logra 30.058 SAPS por unidad de rack.

En otras palabras, para lograr el mismo rendimiento, un entorno SAP totalmente virtualizado basado en Nutanix sólo requiere un tercio del espacio del centro de datos (véase la Figura 3, más abajo). A la vista de las características del software de infraestructura de Nutanix, que no son en absoluto exhaustivas, la preocupación por los entornos SAP virtualizados ya no parece justificada.

Este hallazgo ofrece a los responsables de SAP la libertad de organizar su infraestructura estrictamente en función de criterios empresariales. Menores costes de infraestructura de hasta el 60%, menores requisitos de energía y refrigeración de hasta el 90%, una reducción radical del esfuerzo administrativo gracias a la automatización, mayor libertad en la elección de ofertas de hardware y compatibilidad con pilas de nube pública comunes para escenarios híbridos, etc.: todas ellas son ventajas importantes que solo pueden conseguirse de forma muy limitada con las infraestructuras tradicionales.

Los entornos SAP virtualizados basados en el software HCI de Nutanix no solo ayudan a ahorrar costes a corto plazo, sino que también reducen el coste total de propiedad de los entornos SAP actuales y futuros y facilitan la transición a la nueva generación de productos de Walldorf.

Valpak, cliente de Nutanix

Valpak acelera su negocio tradicional y en línea

Tras la adquisición de Savings.com por Valpak, la empresa británica de cumplimiento de normativas necesitaba una infraestructura más sencilla y rentable para soportar cargas de trabajo como SAP, Oracle y SQL Server. Al mismo tiempo, el equipo de TI no necesitaba crecer demasiado y debía ser más ágil sin comprometer la estabilidad. El rendimiento también debía aumentar. Al utilizar el software de infraestructura de Nutanix, Valpak:

- acelerar sus despliegues en un factor de 10

- Multiplica por 8 el rendimiento

- Reducir el tiempo de administración de 180 horas al mes a sólo 2 horas

- redujo sus gastos de capital en una décima parte y desde entonces ha permitido que su infraestructura informática crezca al ritmo de la demanda

ASM para clientes de Nutanix

ASM crea informes por lotes 5 veces más rápido que antes

ASM International, con sede en los Países Bajos, es uno de los principales proveedores de equipos de fabricación de obleas para la industria de semiconductores. ASM buscaba un sustituto para su anticuada infraestructura que sustituyera el lento procesamiento por lotes por otro más rápido. También querían aliviar a su equipo de operaciones de TI de los constantes problemas con el hardware que soportaba aplicaciones tan diversas como SAP ERP, CRM, SCM, PI, BW, BOBJ, PLM, SRM, PORTAL, etc. Con la ayuda de Nutanix Enterprise Cloud, ASM:

- ha multiplicado por 5 la velocidad de procesamiento por lotes para satisfacer las crecientes exigencias del mercado

- Reducción de casi un tercio del tiempo de funcionamiento.

- mejoró el paisaje de su sistema entre un 50% y un 500%, según la zona

- consolidación de las máquinas virtuales para SAP y las bases de datos, con el consiguiente ahorro en costes de licencia

Cliente de Nutanix: Empresa multinacional del sector alimentario

Una multinacional alimentaria moderniza su entorno SAP

Una conocida empresa de alimentación buscaba la forma de realizar nuevos proyectos empresariales con mayor rapidez que antes. Sin embargo, el tiempo necesario para las nuevas implantaciones en la infraestructura existente con cargas de trabajo como Electronic Data Interchange (B2BI), Order-to-Cash (SAP NetWeaver y B2BI), SAP Project Staging (CRM, aplicaciones BW) y otras aplicaciones era demasiado elevado. Como resultado, los objetivos empresariales, cada vez más ambiciosos, ya no podían cumplirse. Además, la empresa sufría de falta de espacio en sus centros de datos, necesitaba controlar los costes continuos de almacenamiento y buscaba una solución que le permitiera empezar a aplicar su estrategia de nube inmediatamente. El equipo de TI se puso manos a la obra para reconstruir su enorme entorno UNIX utilizando servidores Linux virtualizados ejecutados en Nutanix Enterprise Cloud. Los resultados no se hicieron esperar:

- 40% menos

- Coste total de propiedad (TCO)

- reducción masiva de la

- Huellas totales

- Desmantelamiento del

- Infraestructura SAN

- Implantación y distribución más ágiles de nuevas implantaciones

- adelgazado

- Procesos de actualización

- un claro

- Hoja de ruta de la nube