El camino desde la idea hasta la producción

No es ningún secreto que todas las empresas del mundo están trabajando para aprovechar el potencial de la IA, y de la IA generativa en particular. Las empresas saben que la IA puede aumentar la eficiencia, reducir costes, mejorar la satisfacción de clientes y empleados, crear ventajas competitivas y automatizar los procesos empresariales. Todo esto es posible a medida que la tecnología se vuelve más fácilmente disponible y accesible para organizaciones de todos los tamaños. Gracias a las numerosas opciones de implantación y a las diversas combinaciones de hardware y software, el acceso a las tecnologías de IA y ML es ahora más sencillo.

Además, las empresas ya no necesitan un despliegue completo de IA/ML para utilizar determinadas funciones, como los servicios de IA basados en la nube o las herramientas empresariales asistidas por IA. En consecuencia, se prevé un aumento de las inversiones en tecnologías de IA. Sin embargo, el mercado de la IA está actualmente muy fragmentado. En este entorno, a las empresas a menudo les resulta difícil elegir el camino correcto. Sobre todo, se enfrentan al reto de poner en producción modelos de IA de forma eficiente y segura. Incluso las empresas que han completado con éxito sus primeros proyectos de IA dudan o no consiguen una transformación completa. Esto se debe a numerosas razones.

Muchas empresas temen la dependencia de un proveedor y reconocen los peligros y riesgos de la tecnología de IA. Otras, en cambio, consideran que la personalización de los modelos de IA en función de las necesidades es una tarea difícil de resolver. En vista de estos retos, muchos proyectos de IA siguen estancados en la fase piloto o de prueba de concepto.

El enfoque de Red Hat de la ingeniería de IA y ML se basa al 100% en el código abierto.

El modelo de IA adecuado

Sólo un enfoque estratégico que plantee y responda a preguntas fundamentales antes de la introducción de la IA puede garantizar el éxito. Por encima de todo, esto incluye seleccionar los modelos de IA adecuados y la plataforma o base de infraestructura apropiada.

Existe una tendencia clara a la hora de decidirse por un modelo específico de IA. Cada vez más empresas optan no por los LLM, sino por modelos más pequeños diseñados para casos de uso específicos. El problema de utilizar modelos más grandes -con miles de millones de parámetros- es que, aunque tienen amplios conocimientos genéricos, no son especialmente útiles si una empresa quiere crear un chatbot para su personal de atención al cliente o ayudar a los clientes a resolver un problema específico con un producto o servicio. En comparación con los LLM, los modelos más pequeños ofrecen numerosas ventajas. Son más fáciles de implementar y permiten la integración continua de nuevos datos, especialmente datos específicos de la empresa y del dominio. Esto significa que los cursos de formación también pueden llevarse a cabo mucho más rápido con ellos.

Los modelos también contribuyen a un importante ahorro de costes, ya que los grandes LLM requieren una inversión considerable. Por último, pero no por ello menos importante, al utilizar modelos más pequeños, las empresas también pueden reducir su dependencia de los grandes proveedores de LLM, cuyas soluciones suelen ser una caja negra en cuanto a algoritmos, datos de entrenamiento o modelos. En general, existe actualmente una tendencia en la industria hacia el suministro de modelos de IA más pequeños y optimizados de todos modos. Un ejemplo de ello es el enfoque vLLM (Virtual Large Language Model). Esto permite realizar cálculos más rápidamente con un servidor de inferencia, por ejemplo, utilizando la memoria de la GPU de forma más eficiente.

Proyecto InstructLab

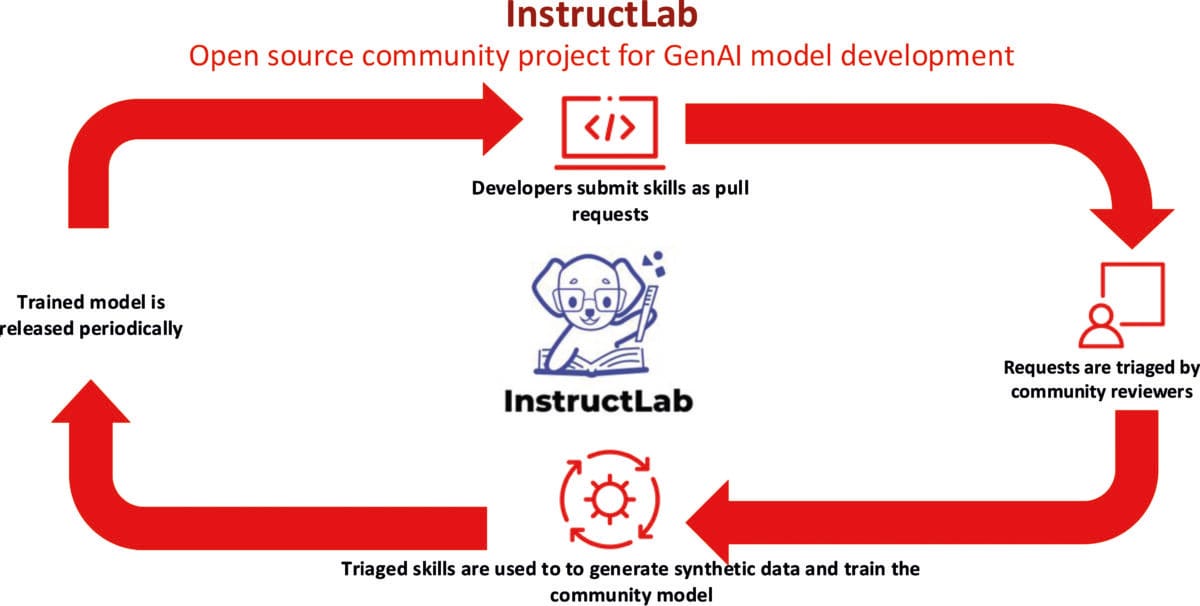

Sin embargo, los LLM genéricos, que presentan diversos grados de apertura en cuanto a datos previos a la formación y restricciones de uso, ahora también pueden ampliarse para un fin empresarial específico. Con este fin, Red Hat e IBM han lanzado el proyecto comunitario InstructLab, que ofrece una solución rentable para mejorar los LLM. La solución requiere muchos menos datos y recursos informáticos para volver a entrenar un modelo. InstructLab reduce significativamente la barrera de entrada al desarrollo de modelos de IA, incluso para usuarios que no son científicos de datos.

En InstructLab, expertos en la materia de diversos campos pueden aportar sus conocimientos y experiencia y, de este modo, seguir desarrollando un modelo de IA de código abierto y de libre acceso. También es posible utilizar la técnica RAG (Retrieval Augmented Generation) para optimizar aún más un modelo acordado con InstructLab. Por lo general, la RAG ofrece la opción de complementar los datos disponibles en un LLM con fuentes de conocimiento externas con datos actuales en tiempo real, información contextual, propia o específica del dominio, como repositorios de datos o documentación existente. Esto también facilita en gran medida que los modelos proporcionen respuestas correctas y fiables sin alucinar.

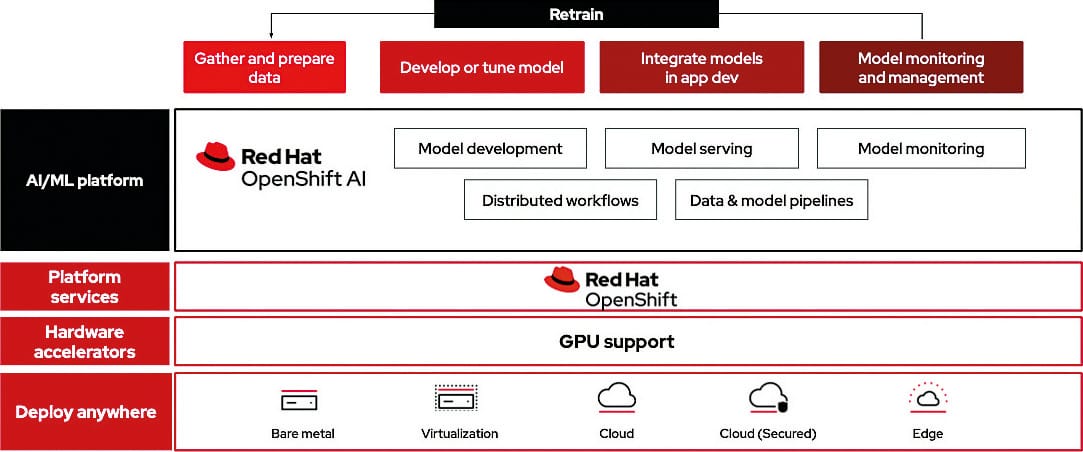

Con Red Hat OpenShift AI, una plataforma de IA/ML flexible y escalable, las empresas pueden desarrollar e implementar aplicaciones impulsadas por IA en entornos de nube híbrida.

IA de código abierto

No hay duda de que las empresas necesitan comprometerse cada vez más con nuevos temas como la IA y el ML para seguir siendo competitivas y estar preparadas para el futuro. Sin embargo, el uso incondicional y acrítico no es justificable. Siempre hay que garantizar la seguridad, la estabilidad y la soberanía digital.

La soberanía tiene que ver sobre todo con la tecnología, el funcionamiento y los datos. Las empresas deben garantizar la independencia de los proveedores, tanto en lo que respecta a la elección entre componentes propietarios y de código abierto como a las opciones de despliegue flexible. La soberanía de los datos significa que las empresas saben dónde y cómo se almacenan y procesan sus propios datos.

En el contexto de estos requisitos de soberanía, los principios, tecnologías y soluciones transparentes de código abierto son cada vez más importantes. Especialmente cuando la IA se utiliza en áreas críticas para la empresa, debe garantizarse siempre un alto grado de trazabilidad y explicabilidad. Al fin y al cabo, las empresas no quieren una caja negra, sino una IA fiable y explicable que respete los principios legales y éticos. El valor de los procesos de código abierto probados y comprobados, que defienden un alto nivel de transparencia como en el ámbito del desarrollo de software, es particularmente evidente en la implementación.

Sin embargo, en el sector de la IA, al igual que en el desarrollo de software en general, también existe el riesgo del lavado de cara del código abierto, como demuestra una comparación de los elementos centrales del software de código abierto y los LLM de código abierto. El software de código abierto se caracteriza por su total transparencia, algoritmos comprensibles, gestión visible de errores y la posibilidad de impulsar un mayor desarrollo con la participación de la comunidad. Por el contrario, aunque muchos de los llamados LLM de código abierto se caracterizan en general por su libre disponibilidad, ofrecen poca información sobre aspectos comparables al desarrollo de software, como los datos de entrenamiento, las ponderaciones, los guardarraíles internos del modelo o una hoja de ruta fiable.

Sin embargo, desde la perspectiva de una empresa, la trazabilidad y la base de datos son de importancia fundamental, aunque solo sea por motivos de responsabilidad o de cumplimiento normativo. Una IA fiable también es esencial en muchos casos debido a los elevados requisitos normativos derivados del GDPR o la Ley de IA de la UE, por ejemplo. Un enfoque de código abierto es la base adecuada para ello, ya que ofrece transparencia, innovación y seguridad. Sin embargo, debe ser genuinamente de código abierto y cumplir criterios clave de código abierto -incluidos los relativos a los datos de formación o los modelos de IA- y no limitarse a un lavado de cara de código abierto.

La plataforma adecuada

Sea cual sea el camino que decida tomar una empresa: utilizar un LLM o varios modelos más pequeños: La plataforma utilizada es siempre una parte importante del entorno de IA. Muchas empresas siguen confiando en sus propias infraestructuras y servidores locales. Sin embargo, este enfoque limita la flexibilidad para introducir tecnologías innovadoras como la IA. Sin embargo, el mercado de la nube ha evolucionado y ofrece lo mejor de ambos mundos: la nube híbrida. Permite a las empresas seguir utilizando el almacenamiento local para los datos sensibles y, al mismo tiempo, aprovechar las ventajas de escalabilidad de la nube pública.

InstructLab es un proyecto de código abierto para mejorar los LLM. El proyecto comunitario lanzado por IBM y Red Hat permite la experimentación simplificada con modelos generativos de IA y la adaptación optimizada de modelos.

Nube híbrida para la IA

Por lo tanto, una plataforma de nube híbrida es también una base de infraestructura ideal para la implementación segura de la IA, desde el desarrollo de modelos de IA y la formación de modelos de IA hasta la integración de modelos de IA en aplicaciones y el funcionamiento de los modernos servicios MCP (Model Context Protocol) y A2A (Agent to Agent). La nube híbrida ofrece una flexibilidad muy necesaria a la hora de elegir el mejor entorno para las respectivas cargas de trabajo de IA. Las empresas pueden darle dos usos. Pueden desarrollar y entrenar un modelo de IA en una nube pública en granjas de GPU con una clara separación del cliente, utilizando también datos disponibles públicamente y datos de prueba sintéticos, e incrustarlo después en la aplicación local. Por último, también hay que tener en cuenta que, por lo general, las empresas no pueden crear su propia infraestructura de GPU de alto coste. Por el contrario, también pueden entrenar los modelos con datos confidenciales en su propio centro de datos y luego operarlos en una nube pública.

Las funcionalidades MLOps (Machine Learning Operations) son un componente importante de una plataforma diseñada para el uso de IA. MLOps es similar al concepto establecido de DevOps, aunque se centra en la provisión, el mantenimiento y el reentrenamiento de los modelos de aprendizaje automático. Sobre todo, MLOps contribuye a una colaboración eficaz y optimizada entre la ciencia de datos, los equipos de desarrollo de software y las áreas operativas. Tiende un puente entre el desarrollo de modelos de ML y su uso en un entorno productivo. Las prácticas MLOps orientadas a la simplificación, la automatización y el escalado contribuyen así también a una aceleración significativa del despliegue en producción.

Para reducir la complejidad operativa, una plataforma también debe ofrecer herramientas avanzadas para automatizar los despliegues y el acceso autoservicio a modelos y recursos. Esto permite a las organizaciones gestionar y escalar sus propios entornos para la formación y el despliegue de modelos según sea necesario. También es importante disponer de herramientas de IA/ML probadas y compatibles.

Por último, pero no por ello menos importante, un enfoque de plataforma también garantiza que los socios de la industria, los clientes y la comunidad de código abierto en general puedan cooperar eficazmente para impulsar las innovaciones de la IA de código abierto. Existe un inmenso potencial para ampliar esta colaboración abierta en el campo de la IA, especialmente en el trabajo transparente sobre los modelos y su entrenamiento.

Despliegue de producción de IA

De este modo, el mundo de la IA puede abrirse y democratizarse aún más. Para los usuarios de IA, la apertura de la plataforma para una red de socios de hardware y software es una ventaja clave: les da la flexibilidad que necesitan para implementar sus casos de uso específicos. Estas plataformas flexibles e híbridas para el uso productivo de la IA ya están disponibles, como demuestra el ejemplo de Red Hat OpenShift AI. Esto permite a una empresa descartar la dependencia de un proveedor, seguir el ritmo de las nuevas innovaciones en IA e implementar todos los casos de uso posibles. Admite el entrenamiento y la puesta a punto de modelos, así como el suministro y la supervisión de todos los modelos y aplicaciones de IA en la nube, en el perímetro y en las instalaciones. La flexibilidad y la compatibilidad están garantizadas por una estructura modular y una funcionalidad plug-and-play con componentes de código abierto y otras soluciones de IA. Con esta base de soluciones, las empresas pueden impulsar de forma gradual y sencilla la introducción de la IA y mantener así los costes bajo control.

Muchas empresas se encuentran todavía en una fase de evaluación o prueba de concepto cuando se trata de introducir la IA. Aunque actualmente se presta mucha atención a los grandes modelos lingüísticos y a la IA generativa, no hay que olvidar una cosa: Aunque la transferencia de la IA a gran escala al entorno de producción es un tema bastante nuevo, no afecta en absoluto solo a los LLM, sino también a la IA predictiva o analítica, por ejemplo. Aquí también hay retos que, en última instancia, sólo pueden superarse con un enfoque de plataforma.

Continúe con la entrada del socio: